14/07/2010

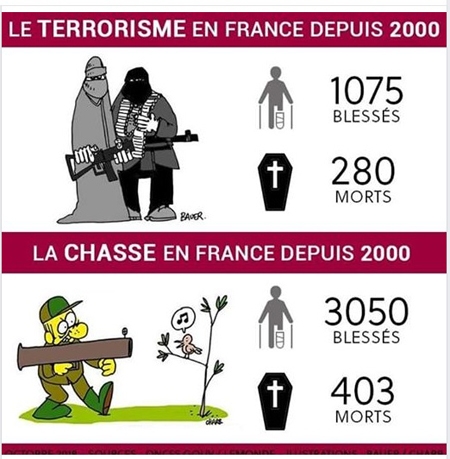

Jean-Louis Borloo : l’État à la botte des chasseurs

Jean-Louis Borloo : l’État à la botte des chasseurs

par Luce Lapin

Le 2 juin dernier, la FNC (Fédération nationale des chasseurs) reproche, dans un communiqué de presse, à Jean-Louis Borloo de n’avoir pris « aucune mesure tangible […] contre les saboteurs de chasse ».

Seulement deux jours plus tard, le 4 juin, le gouvernement français, sous l’impulsion du ministre de l’Écologie et des Fusils (contrairement à ce que l’on pourrait logiquement supposer, l’un n’empêche absolument pas l’autre), cède au lobby des chasseurs à courre en édictant, par décret, une contravention de cinquième classe, passible de 1 500 euros d'amende, pour « obstruction à un acte de chasse ».

CPNT (Chasse, Pêche, Nature, Traditions, 7 juin), le parti de l’extrême chasse allié à la droite dure, est content : « Grâce au partenariat CPNT – UMP, les chasseurs obtiennent une grande victoire, attendue depuis longtemps, contre les anti-chasse. »

En primeur dans le numéro 739 de Charlie Hebdo, la réaction inédite de Gérard Charollois président de CVN (Convention Vie et Nature pour une écologie radicale), dans un entretien qu’il a donné aux « Puces ». Trois autres associations de protection animale nous font également part ici de leur ressenti.

Pour moi, quoi qu’il en soit, je n’y dérogerai pas : l’objectif, c’est tolérance zéro. Ni chasse à courre, ni chasse tout court !

Document Charlie Hebdo

10:55 Publié dans Environnement-Écologie | Tags : chasse, protection de la nature | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

Massacre de blaireaux : Côte-d’Or, côte d’horreur

Massacre de blaireaux : Côte-d’Or, côte d’horreur

par Pierre Athanaze, président de l’ASPAS

L’ASPAS, Association pour la protection des animaux sauvages, vient d’adresser une lettre ouverte, cosignée par 71 associations, au préfet de Côte-d’Or pour lui demander de «mettre fin à la plus grande destruction de blaireaux qui ait été entreprise en France».

« En mars dernier, le préfet de la Côte d’Or a pris des arrêtés ordonnant la capture et la “régulation” de blaireaux sous le prétexte de dépister et lutter contre la tuberculose bovine, pouvant être véhiculée par le mustélidé. À ce jour, ce sont plus de 2 050 individus qui auraient été exterminés par les chasseurs, piégeurs, déterreurs et lieutenants de louveterie du département. 71 associations de protection de la nature s’insurgent contre cette véritable opération de destruction massive en adressant une lettre ouverte au préfet, en cette année déclarée “année nationale de la biodiversité”. Certes, le problème de la tuberculose bovine doit être résolu. Cependant, en France, cette maladie n’est qu’anecdotique chez le blaireau. Des études scientifiques (1) ont démontré que non seulement la destruction de blaireaux n’enraye en rien la maladie, mais qu’au contraire, elle augmenterait l’incidence de la tuberculose bovine sur le cheptel bovin ! Le Conseil de l’Europe (2), pour sa part, a indiqué qu’“On peut douter que l’élimination des blaireaux ait une utilité, et l’on ne devrait certainement pas y recourir” et qu’“On ne doit jamais procéder à l’élimination générale des blaireaux.”

Vu la vitesse d’éradication de l’espèce sur le département, l’avenir du Blaireau en Côte-d’Or est indiscutablement en péril. La période de destruction a débuté lors de la saison de reproduction et s’est même poursuivie pendant la période de sevrage des jeunes. Suite à un tel recul des effectifs, comment rétablir une densité de population normale et viable de l’espèce alors que la dynamique de population est connue pour être faible ? Si des mesures qui semblent disproportionnées ont été prises à l’encontre du blaireau, il n’en est pas de même vis-à-vis d’autres usages qui pourtant sont de très forts vecteurs de la tuberculose bovine. En effet, les entrailles des chevreuils laissés dans la nature par les chasseurs (animaux abattus et dépecés sur place) ou la libre circulation de vaches et de taureaux de troupeaux en troupeaux représentent une menace bien plus importante.

Précisons aussi que le Blaireau, inscrit à l'annexe III de la Convention de Berne, est une espèce protégée dans la plupart des autres pays d’Europe. Au lieu de confier cette mission aux services vétérinaires en lien avec les scientifiques et les associations de protection de la nature dans le but de lutter pacifiquement et efficacement contre la tuberculose bovine, ce sont les chasseurs (dont les motivations sont certainement tout autres...) qui se voient autoriser à tuer, sans limites, les blaireaux.

Aussi, nos 71 associations demandent instamment au préfet de la Côte d’Or de bien vouloir mettre fin à la plus grande destruction de blaireaux qui ait été entreprise en France. La lutte contre la tuberculose bovine n’en sera pas affectée si les vraies mesures prophylactiques sont réellement mises en place. »

Pierre Athanaze, président de l’ASPAS

30 juin 2010

(1) Christl A. Donnelly et al., 2003. Impact of localized badger culling on tuberculosis incidence in British cattle. Nature 426 : 834-837

(2) Huw I. Griffiths & David H. Thomas, 1998. La conservation et la gestion du blaireau d’Europe (Meles meles). Sauvegarde de la nature n°90, Conseil de l’Europe : 84p

Associations signataires

À Pas de Loup, Adeo Animalis, APIE, ASPAS, Association I.D.A.E., Association MELES, Association SEVE, Association Végétarienne de France, Autun Morvan Ecologie, AVES France, Borda, Centre Athénas, CHENE, CLAM, Code Animal, Combactive, Comité Ecologique Ariégeois, Connaissance & Protection de la Nature du Brabant, Convention Vie et Nature, CORA Faune Sauvage, CORA-Rhône, CPEPESC, Dignité Animale, Doubs Nature Environnement, Droits Des Animaux, FERUS, Fondation 30 Millions d’Amis, Fondation Assistance aux Animaux, Fondation LFDA, Fourrure Torture, France Nature Environnement Hautes-Pyrénées, Franche-Comté Nature Environnement, Groupe Mammalogique Normand, JardinRefuge, Jura Nature Environnement, L214, LausAnimaliste, Le Pic Vert, L'empreinte, Les Naturalistes Rhodaniens, Loiret Nature Environnement, LPO Drôme, Maison de l'Espoir, Mayenne Nature Environnement, Mille-Traces, Natagora, Naturalistes Chapellois, Nature et Humanisme, Notre Dame de Toute Pitié, Oiseaux-Nature, One Voice, OUSIA, Perche Nature, Philippe Hervieu au nom du groupe Europe écologie au conseil régional de Bourgogne, Rassemblement Anti Chasse, Refuge de l'Arche de Noé, Respect et Défense des Animaux, Sauvegarde de la Faune Sauvage, SECAS, Secourisme Animalier, Serre Vivante, SFEPM, SHNPM, SNDA, Société Nationale de Protection de la Nature, SOS Rivières Et Environnement, SPA Marseille Provence, Territoire de Belfort Nature Environnement, Ultimathera 21, VegAsso.

10:19 Publié dans Environnement-Écologie | Tags : blaireau, chasse, écologie, protection de la nature, régulation des populations, dynamique de population | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

05/07/2010

Mort annoncée de l'écologisme défensif et militant

Coup dur : une fondation pour l’agonie de Gaïa

Coup dur : une fondation pour l’agonie de Gaïa

ou la mort annoncée de l’écologisme défensif et militant

par Michel Tarier (écologue, écosophe)

La fondation Claude Allègre Écologie d’avenir, qui deviendra bien vite, purement et simplement pour semer le trouble, la fondation Écologie d’avenir, dit vouloir rassembler tous ceux qui pensent que "seuls les progrès de la connaissance et les innovations techniques permettront de résoudre les problèmes qui se posent à la planète".

On retrouve derrière ce projet nombre de poids lourds du CAC 40 et bien des personnalités ralliées au climato-scepticisme, non pas par pure et louable opinion scientifique (Kokopelli est relaxé !), mais par souci strictement cupide d’être du bon côté. On peut désormais parier que le noyau dur et fondateur sera rejoint par d’innombrables opportunistes.

Voici donc une nouvelle opération pompe à blé, montée par des gens pour lesquels les écosystèmes et la biodiversité ne représentent qu’une inépuisable banque. Dans ce ralliement, vous ne trouverez aucun chercheur de terrain, aucun écologue expérimenté, le club n’étant formé que de VRP d’économie verte atteints du déni de réalité, fidèles serviteurs des transnationales, rompus aux combines les plus sournoises, dont la niche écologique n’est pas le sanctuaire de la Nature mais les corridors des ministères et les grandes tables des mégapoles.

Décidément, notre avenir ne sent pas bon. L’écologi(sm)e, de plus en plus dévoyé(e), est en passe de sortir définitivement de sa dimension originelle, celle principielle et spirituelle des forces de la vie, pour devenir le nouveau fer de lance d’une économie de marché en plein délabrement. Il ne fait plus aucun doute que nos enfants seront les esclaves d’une planète-poubelle.

De fil en aiguille

Après un premier tour de passe-passe, par l’entremise non-innocente de l’homme du pacte qui… empaqueta l’écologisme dans l’écologie, puis l’écologie dans l’environnement anthropocentriste, pour remettre le kit complet entre les mains de l’ami de la Terre éco-vertueux et de grande conviction qu’est Sarkozy, voici l’ultime menace, celle de l’habile récupération de la cause par la frange pure et dure du système, symbolisée par l’ex-Monsieur le ministre pro-amiante de Jussieu.

De René Dumont à une économie verte ultralibérale, d’un souci de consommer écoconsciemment à l’imposture d’un développement annoncé comme durable paradoxalement à la finitude du monde, il ne fallu pas un demi-siècle pour rendre exsangue la substantifique moelle de la contre-culture écologique. On oubliera, entre-temps, les insultes d’Allègre à l’endroit de Hulot, et le rôle de vierge effarouchée de ce dernier, tout cela pouvant relever d’un numéro de duettistes. Du cirque, encore du cirque, rien que du cirque. Ceci pour la France grenellienne, évidemment centre du monde et des équilibres écosystémiques !

Par ses positions favorables à l’establishment de l’écologiquement correct et le réajustement d’une écologie qui se devait coercitive en une écologie aléatoire, domestiquée, qui flatte et peu rapporter encore plus gros que prévu, ce type (Claude Allègre) risque bien d’accéder aux plus hautes fonctions. À nous les OGM, à nous la pétrochimie et son agroterrorisme, à nous les cancers environnementaux, à nous les Tchernobyl à l’Américaine avec des océans englués de pétrole. Adieu bienveillante écosophie, adieu principes de précaution susceptibles de ralentir la machine à massacrer le peu qui reste de paradis sur Terre.

L’auteur de livres mensongers et qui se vendent à la criée cherche à remettre les clés de l’écologie au pouvoir des marchands. Pour l’instant, ceux-ci feignaient de faire la fine gueule. Vous allez voir comme ils vont sauter sur l’occasion, faisant passer Allègre pour un nouveau Galilée. Beau cadeau pour la planète, joli coup de pouce pour notre avenir. Et son ami démographe Hervé Le Bras vous ferra oublier le troisième enfant occidental carboné contre lequel Yves Cochet nous mettait judicieusement en garde.

Pour élargir le plan, j’en suis à me demander si des instances comme le GIEC, tout compte fait elles-mêmes inspirées par des requins verts de la trempe d’un Al Gore (douteux le brillantissime déclencheur d’alerte…) ne sont pas à l’origine d’un frenchy Allègre. Localement en ce monde sans foi ni loi, d’autres Allègre doivent simultanément voir le jour et donner "l’orientation qu’il faut" à ce satané souci écologique décidemment trop inquiétant pour les banques, y compris pour celles d’Attali. Les maîtres du monde dénoncent ainsi eux-mêmes les misères qu’ils créent et gardent la barre en instaurant un juteux marchés des apparences. Ce ne sont pas les ONG qui manquent pour les crédibiliser de leurs sceaux immaculés à l'effigie lénifiante d'animaux sympathiques (les autres pouvant crever...). C’est qu’en ces temps d’amalgames, de mensonges et de dénis, "ils" nous rendraient facilement paranos… Le très cynique sponsoring du film Home du très photographe YAB avait déjà eu le courage d’aller très loin dans l’association des milliardaires et de leurs firmes à la dénonciation des disparités Nord-Sud, des pollutions et de la déconstruction des écosystèmes. Quand Pinault sort ses griffes, c’est des marques dont il s’agit !

Il serait peut-être urgent d’envisager le sauvetage de quelques éléments sains, non contaminés par miracle ou étanchéité à toute épreuve, colibris instrumentalisés à leur insu dans ce grand guignol de charognards véreux ! Ou et en d’autres termes, "Pierre Rabhi existe-t-il vraiment ? !".

Gargarismes, cosmétiques, vernis et badigeons…

Dans sa version contrition écologique, pour s’assurer l’exclusivité du thème de la crainte planétaire et climatique, pour désamorcer d’avance toute tentative de remise en question, pour renforcer ses positions et continuer à ronger les ressources jusqu'à l’agonie finale, le capitalisme ne cesse d’accoucher de monstres. Nous, infiniment naïfs et de bonne volonté, écosujets indûment baptisés écocitoyens aux gestes salvateurs tant dérisoires, nous plongeons dans la combine et nous nous regardons dans la glace : avec notre compost et notre petit vélo, nous nous trouvons beaux ! Ainsi, et pour l’écologisme à la française, un Borloo et son Grenelle nous embellissent l’âme. Ils ne font rien d’autre que leur propre cuisine, avec Bouygues & Co en arrière-boutique. L’autocritique parodique et l’auto-dénonciation sont les meilleures tactiques qui soient. Elles permettent, qui plus est, d’apporter les solutions dans une pochette surprise, d’en faire déballage et étalage comme ça, innocemment, un après-midi chez n’importe quel Drucker aux courbettes obligées. C’est en fait le coup des pièces jaunes version écologie. La pathétique grenouille de bénitier tire des larmes de crocodiles au bon populo tandis que son si sympathique président de mari vaque à de biens sordides affaires, comme l’affaire Karachi pour ne citer que celle qui fait l’actualité.

La fondation Claude Allègre Écologie d’avenir :

http://www.mediapart.fr/article/offert/2f106b2fad1f691b7d69c837e1226573

http://effetsdeterre.fr/2010/06/30/le-mammouth-du-deni-cl...

Ce juteux marché des apparences :

http://www.lesechos.fr/info/analyses/020621365231-les-deu...

Home story (génial !) :

Partie 1 : http://www.dailymotion.com/video/xbqyr7_home-12_news

Partie 2 : http://www.dailymotion.com/video/xbr0bm_home-22_news

09:26 Publié dans Environnement-Écologie | Tags : écologie, écologisme, climat, climatosceptique, michel tarier, claude allègre | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

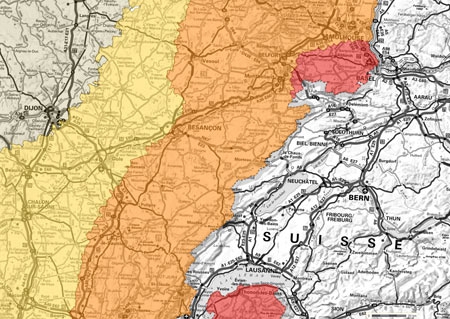

Menaces sur le Doubs franco-suisse

Menaces sur le Doubs franco-suisse

Les associations françaises et suisses de protection de l’environnement (CPEPESC, Pro Natura Jura, FCNE, DNE, SDV, ANPER-TOS), les associations de pêche (Fédération de Pêche du Doubs, la Franco-Suisse, la Gaule, l’Hameçon, la Truite de Grand’Combe des Bois) refusent que la rivière soit sacrifiée au bénéfice de l’hydroélectricité.

C’est un règlement d’eau datant du 5 février… 1969 qui régit le fonctionnement en principe coordonné des trois usines hydroélectriques situées sur le Doubs franco-suisse : le Châtelot, le Refrain et la Goule. Si la synergie dans le fonctionnement des trois ouvrages est nécessaire pour atténuer l’impact sur le milieu aquatique, la réalité depuis les années 2000 est tout autre : les marnages (variations de hauteur d’eau sous l’action des éclusées) autorisés à l’époque avaient été revus à la baisse en 2003

C’est un règlement d’eau datant du 5 février… 1969 qui régit le fonctionnement en principe coordonné des trois usines hydroélectriques situées sur le Doubs franco-suisse : le Châtelot, le Refrain et la Goule. Si la synergie dans le fonctionnement des trois ouvrages est nécessaire pour atténuer l’impact sur le milieu aquatique, la réalité depuis les années 2000 est tout autre : les marnages (variations de hauteur d’eau sous l’action des éclusées) autorisés à l’époque avaient été revus à la baisse en 2003

suite à une catastrophe survenue un an plus tôt. En effet, en raison du comblement de la Retenue de Biaufond, il avait été reconnu que la poursuite des anciennes valeurs de marnage conduisaient à la mise à sec de plusieurs hectares de zones peu profondes, les plus riches en biodiversité, provoquant de considérables mortalités. Dès lors la retenue de Biaufond dont le comblement s’est encore accentué (jusqu’à 10

suite à une catastrophe survenue un an plus tôt. En effet, en raison du comblement de la Retenue de Biaufond, il avait été reconnu que la poursuite des anciennes valeurs de marnage conduisaient à la mise à sec de plusieurs hectares de zones peu profondes, les plus riches en biodiversité, provoquant de considérables mortalités. Dès lors la retenue de Biaufond dont le comblement s’est encore accentué (jusqu’à 10  cm par an au niveau du parking) ne peut plus jouer son rôle de régulation des éclusées du Châtelot, telles qu’elles sont programmées aujourd’hui.

cm par an au niveau du parking) ne peut plus jouer son rôle de régulation des éclusées du Châtelot, telles qu’elles sont programmées aujourd’hui.

Cette situation est devenue insupportable sur tout le linéaire de la rivière en aval de ces ouvrages, et l’on apprend aujourd’hui que l’un des essais parmi ceux proposés aurait une incidence écologique majeure.

Cette situation est devenue insupportable sur tout le linéaire de la rivière en aval de ces ouvrages, et l’on apprend aujourd’hui que l’un des essais parmi ceux proposés aurait une incidence écologique majeure.

Cet essai consisterait à descendre en dessous du marnage utilisé actuellement et ceci

dans le but d’être pérennisé.

C’est un inacceptable retour à l’incident de 2002 qui pourrait réduire à néant ce haut lieu de biodiversité aquatique, mais aussi ornithologique.

Si on démodulait les éclusées du Châtelot de cette manière au niveau de Biaufond, cela équivaudrait à continuer de condamner le Doubs neuchâtelois à subir de plein fouet ces  éclusées.

éclusées.

Aucune étude et mesure d’accompagnement n’est prévue aujourd’hui pour détecter et analyser les paramètres extérieurs (températures, qualité physico-chimique et  oxygénation de l’eau) dans les cas extrême d’utilisation de la retenue.

oxygénation de l’eau) dans les cas extrême d’utilisation de la retenue.

Cette démarche pourrait d’ailleurs à court terme tuer la biodiversité des zones à salmonidés situées à l’aval et déjà fragilisées.

De plus, une vidange de la retenue de Biaufond aurait des conséquences dramatiques sur le cours d’eau à l’aval, avec une augmentation de la turbidité, une surcharge organique, une remise en suspension des toxiques piégés dans les sédiments et une élévation de la température sur un milieu déjà fortement stressé.

Les essais, tels qu’ils sont envisagés sont tout à fait incompatibles avec les exigences de la réglementation française sur l’eau et de la DCE (Directive Cadre européenne sur l’Eau). Le SDAGE (Schéma Directeur d’Aménagement et de Gestion des Eaux) Rhône-Méditerranée exige que le principe de non-dégradation de l’état écologique du Doubs soit pris en compte et respecté par toute décision concernant les eaux.

A cet endroit, le lit du Doubs et donc les eaux, sont en grande partie sur le territoire français (mitoyen jusqu’à la borne 66, puis complètement français). Son assèchement doit nécessairement obtenir le feu vert des autorités françaises qui viennent d’approuver le SDAGE fin 2009.

Il serait particulièrement mal venu par ailleurs que, profitant d’installations situées en Suisse, alors que ce pays entretien de constructives et amicales relations de partenariat avec l’Union Européenne, que les objectifs de l’Union Européenne en matière d’eau soient remis en cause de façon spectaculaire par les conséquences inévitables.

La solution passe par le changement des pratiques. On ne peut plus faire fonctionner les ouvrages comme par le passé avec des lâchers d’eau et des coupures brusques qui font crever la rivière. La seule façon de concilier production d’énergie et respect de l’environnement passe par le fonctionnement « au fil de l’eau » des ouvrages.

Les associations de protection de l’environnement et de pêcheurs signataires s’opposent avec fermeté et détermination au projet d’essai de « démodulation » des éclusées du Châtelot.

Elles en appellent aux pouvoirs publics tant français que suisses, pour qu’une telle aberration écologique soit abandonnée. Elles restent extrêmement vigilantes et n’hésiteront pas à saisir les autorités judiciaires compétentes, de part et d’autre de la frontière, pour que le Doubs et les milieux aquatiques qui lui sont associés soient préservés.

Elles informent de cette démarche la Commission Environnement du Parlement Européen.

Contact presse : CPEPESC au 03.81.88.66.71

CPEPESC

AAPPMA La Franco-Suisse

Saône et Doubs Vivant

Pro Natura Jura (CH)

Doubs Nature Environnement (DNE)

Association des pêcheurs La Gaule

Anper-Tos

AAPPMA La Truite de Grand’Combe des Bois

Société de pêche neuchâteloise L’Hameçon

Plateforme franco-suisse pour le Doubs

07:49 Publié dans Environnement-Écologie | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

03/07/2010

Structure du globe terrestre

Structure du globe terrestre

par André Guyard et Serge Warin

(dernière mise à jour du 12 février 2018)

Ajout du 12 février 2018

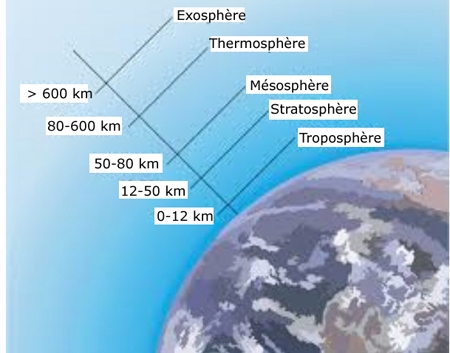

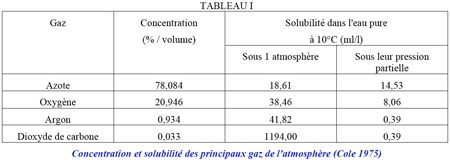

L'article principal est consacré à la structure du globe terrestre. Mais avant de plonger dans les profondeurs de la terre, on peut jeter un coup d'œil sur l'atmosphère, cette couche gazeuse qui nimbe le globe terrestre proprement dit.Cette couche gazeuse est subdivisée en plusieurs enveloppes qu'on classe en partant du sol :

— de 0 à 12 km : la troposphère ;

— de 12 à 50 km : la stratosphère ;

— de 50 à 80 km : la mésosphère ;

— 80 à 600 km : la thermosphère ;

— plus de 600 km : l'exosphère.

Stratification de l'atmosphère terrestre

Cet article s'articule après celui qui présente les techniques d'exploration des profondeurs de la terre. Il sert de préambule à une série de sept articles concernant les volcans de l'Arc antillais, en présentant quelques généralités sur la structure du globe terrestre.

L'existence du volcanisme s'explique par la structure du globe terrestre et dans le cadre de la théorie de la tectonique des plaques.

On trouvera sur le web de bonnes animations vidéo sur la structure interne de la Terre et sur la tectonique des plaques et, publié par notre-planète.info un document récent sur la structure de la Terre (ajout du 30 janvier 2017).

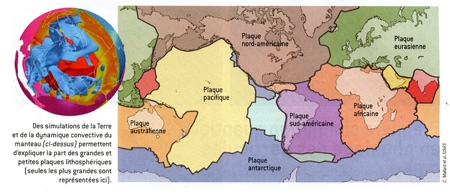

Ajout du 10/09/2016: La subduction contrôle la distribution et la fragmentation des plaques tectoniques terrestres par Claire Mallard,, Nicolas Coltice, Maria Seton, R. Dietmar Müller & Paul J. Tackley

La croûte terrestre est morcelée en un ensemble de grandes et de petites plaques. Cette structure serait le fruit de l'interaction entre les mouvements convectifs du manteau et la résistance de la croûte.

La croûte terrestre est un puzzle de 53 pièces, les plaques tectoniques. Ces pièces se classent en deux catégories, les petites et les grandes. Ces dernières sont seulement au nombre de sept, correspondant à l'Amérique du Nord, l'Amérique du Sud, l'Afrique, l'Eurasie, le Pacifique, l'Australie et l'Antarctique. Ensemble, ces grandes plaques couvrent 94 % de la surface du globe. Entre ces grandes plaques, on trouve 46 petites plaques complémentaires. Pourquoi une telle répartition et quels mécanismes ont conduit à ce découpage ?

Claire Mallard, du Laboratoire de géologie de Lyon, et ses collègues ont réalisé des simulations numériques de Terres fictives en 3D pour comprendre comment la croûte se découpe.

La surface de la Terre est en perpétuel mouvement. Cette idée fut avancée pour la première fois par Alfred Wegener au début du XXe siècle, mais la communauté des géophysiciens mit des décennies à accepter sa théorie de la dérive des continents.

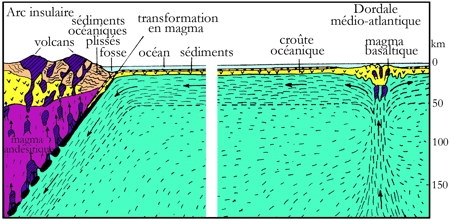

Dans les années 1950-1960, la théorie a été reformulée en termes de tectonique des plaques : la lithosphère — la croûte et la partie supérieure du manteau terrestre — se compose de plaques qui se forment au niveau des dorsales océaniques et disparaissent en s'enfonçant dans le manteau dans les zones de subduction. On peut reconstituer le mouvement des plaques grâce aux anomalies magnétiques enregistrées dans la croûte océanique. Mais celle-ci a une courte durée de vie, si bien qu'il est difficile de reconstruire l'histoire géologique au-delà de 100 millions d'années et d'en déduire les mécanismes sous-jacents.

Les simulations des planètes Terre fictives tridimensionnelles effectuées par l'équipe de Claire Mallard incluent une description des mouvements de convection dans le manteau. Ces calculs prennent en compte de nombreux paramètres, tels que la viscosité et la plasticité du manteau.

Les chercheurs ont retrouvé dans leurs simulations une répartition entre grandes et petites plaques équivalente à celle constatée. Cela confirme que la répartition des plaques tectoniques est liée aux interactions entre la convection mantellique et la lithosphère. En particulier, les chercheurs ont montré que les dimensions des cellules de convection sont comparables à la taille des grandes plaques et que les petites plaques se forment préférentiellement près des zones de subduction, là où les plaques, en s'enfonçant dans le manteau, subissent de fortes contraintes.

Jusqu'à présent, les reconstructions de l'histoire géologique étaient fondées sur des approches statistiques. Elles suggéraient que la lithosphère était principalement composée de grandes plaques, il y a 200 millions d'années. Les plaques se seraient morcelées par la suite. D'autres chercheurs pensaient qu'il devait y avoir plus de zones de subduction dans le passé avec davantage de petites plaques, mais sans pouvoir le prouver.

Cette nouvelle étude appuie cette seconde hypothèse et montre que la répartition entre petites et grandes plaques est restée assez stable sur plusieurs centaines de millions d'années. Les précédents modèles surestimaient, pour le passé, le nombre de grandes plaques au détriment des petites.

C. Mallard et al. (2016) — Nature, vol. 535, pp. 140-143, 2016

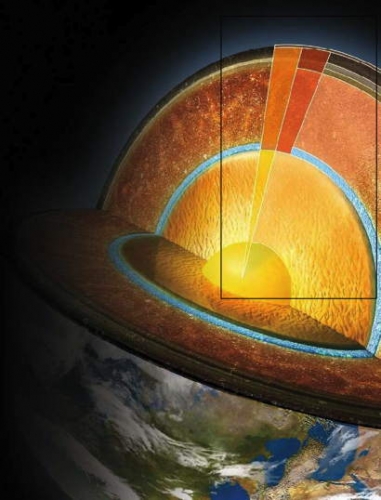

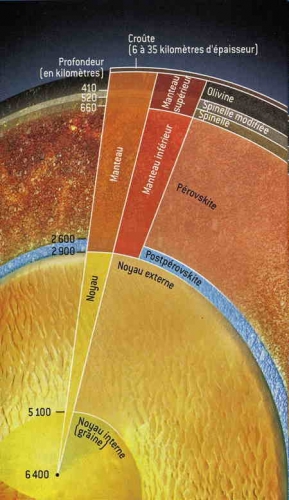

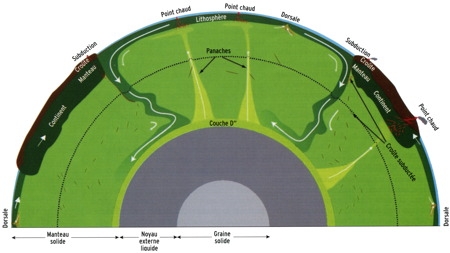

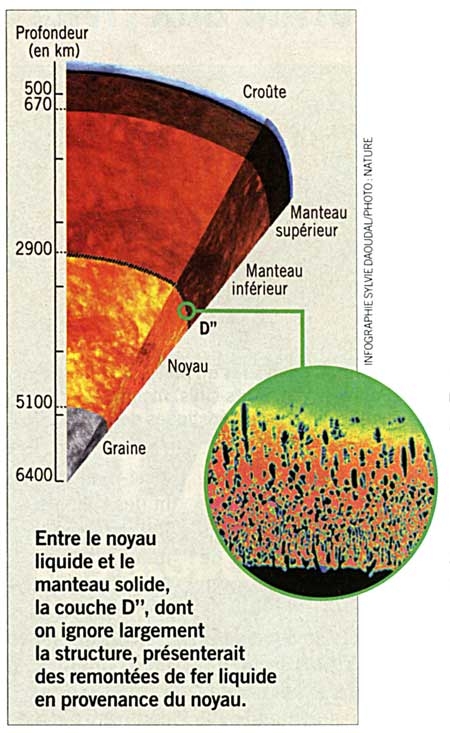

Structure en oignon du globe terrestre

Grâce à l'étude de la propagation des ondes sismiques à travers la planète on a pu démontrer que la Terre a une structure en oignon, les couches concentriques étant composées de différents matériaux.

LA CROÛTE (jusqu'à 35 km de profondeur ; 1% du volume de la terre)

Les continents en partie immergés sous les océans, sont constitués de diverses roches relativement légères, dont l'âge atteint plusieurs milliards d'années. Ils flottent ainsi sur le manteau plus dense. La croûte océanique, formée de roches basaltiques, est un peu plus dense. Elle se forme à partir de matériau du manteau qui émerge au niveau des dorsales sous-marines et qui finit par y retourner en coulant après 100 millions d'années en moyenne.

LE MANTEAU (de 35 à 2900 km ; 83% du volume de la terre)

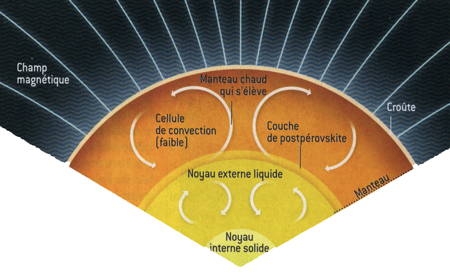

Sous la croûte terrestre se trouve le manteau, masse de roches maintenues sous très haute pression (le magma). Cette masse subit des mouvements de convection. La convection dans le manteau de composition dominée par les silicates est le moteur du volcanisme et de la tectonique des plaques. La chaleur interne est en partie le résidu de la formation planétaire, et en partie produite par la radioactivité du manteau. Le manteau chauffé par le bas, subit des mouvements de convection : la matière froide descend et la matière chaude monte. De sorte que les bords des plaques tectoniques plus froids, vont plonger sous les autres, entraînant activement les plaques et les écartant au niveau des dorsales, constituant ainsi le moteur de la tectonique des plaques. Contrairement à l'idée reçue, ce n'est pas la dorsale qui écarte les plaques. À ce niveau, une simple remontée passive de magma chaud se produit pour combler le vide causé par l'écartement des plaques.

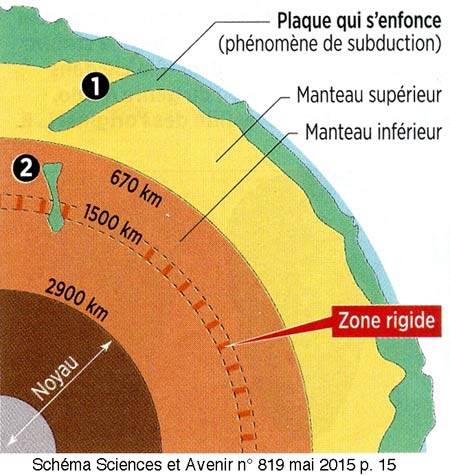

À environ 1500 km de la surface du sol, il y aurait une couche rigide au sein du manteau terrestre. Sa composition est la même que celle du manteau, mais sa viscosité est cent à mille fois supérieure. Cette couche permet d'expliquer pourquoi dans les zones de subduction, là où une plaque tectonique s'enfonce dans le manteau (1), ses fragments ne peuvent aller au-delà de 1500 km (2) : ils butent contre cette région visqueuse, ce qui provoque des tensions et des ruptures et donne naissance à des séismes à foyer profond. C'est la première fois qu'on trouve une explication à ce phénomène. Source : Hauke Marquardt, Université de Bayreuth, Allemagne.

D'après Michel Detay, l'idée que la matière constituant le manteau terrestre (les 2 885 kilomètres séparant la croûte du noyau de la Terre) est en fusion est fausse. Nous ne marchons pas sur un océan de magma, et il n'y a pas de « feu central », car les roches qui constituent le manteau sont à l'état solide. Étant donné l'augmentation de la pression et de la température avec la profondeur, la fusion, même partielle, des roches du manteau — des péridotites, formées de silicates de fer (10 %) et de magnésium (90 %) — est impossible.

Pour autant, une énorme masse d'eau, estimée à l'équivalent de deux à trois hydrosphères, soit deux ou trois fois 1021 kilogrammes – est dissoute dans le manteau. Cette eau s'y trouve soit sous sa forme moléculaire habituelle (H2O), soit sous la forme d'ions hydroxyles (OH–) attachés aux silicates des roches.

Ainsi, l'eau peut faire partie de la formule chimique de certains minéraux, où l'ion OH– est intégré dans la structure cristalline. C'est le cas dans les amphiboles, la lawsonite, la chlorite, etc. Ces deux derniers minéraux contiennent ainsi 14 % d'eau. La présence de cette eau et des gaz dissous dans le magma va jouer un rôle considérable dans le style éruptif des volcans (voir article suivant).

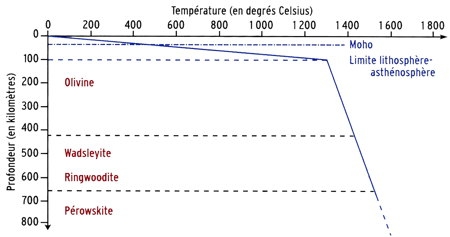

Variation de la température

dans le manteau avec la profondeur

(d'après Thomas, 2010)

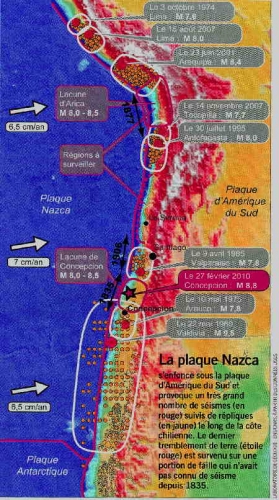

On sait maintenant que la vitesse avec laquelle une plaque tectonique plonge sous une autre est proportionnelle à la largeur de cette plaque. Cette relation a été découverte par Woutter Schellart de la Monash University (Melbourne, Australie) à l'aide d'un modèle numérique reproduisant en 3D des zones de subduction. Elle permet de comprendre par exemple pourquoi la plaque de Farallon, qui plongeait sous l'Amérique du Sud à une vitesse de 10 cm par an il y a 50 millions d'années, ne s'enfonce plus que de 2 cm par an aujourd'hui. Car, dans le même temps, la zone de subduction qui s'étendait sur 14 000 km du nord au sud, s'est réduite à 1400 km. La relation mise en évidence par Woutter Schellart modifie ainsi la vision classique de la tectonique des plaques selon laquelle le déplacement des plaques est le reflet en surface des mouvements de matière au sein du manteau terrestre. Cette nouvelle étude révèle qu'en fait la plaque elle-même exerce un contrôle sur sa propre dynamique (Science & Vie, n° 1120, janvier 2011).

La convection dans le manteau

(d'après Thomas, 2010)

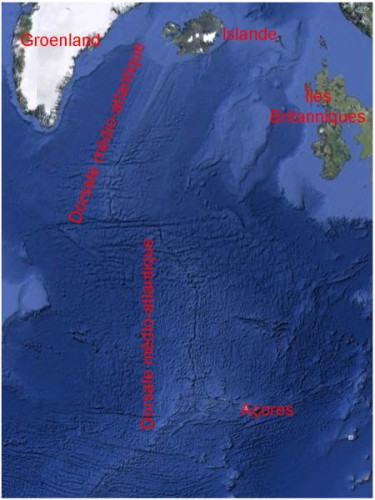

Au niveau de la dorsale médio-atlantique, se produit un mouvement ascendant de magma sous forme d'éruptions généralement sous-marines. Ce magma est principalement constitué de silicium, d'oxygène et de magnésium (bridgmanite). Ces roches nouvelles se déforment au cours des temps géologiques en produisant des courants de convection qui animent le manteau tout entier. Cette convection qui transporte la chaleur interne de la Terre est le moteur de la dérive des continents. Elles alimentent constamment la croûte en formant une sorte de tapis roulant divergeant de part et d'autre de la dorsale et qui repousse les plaques océaniques américaines vers l'Ouest et les plaques océaniques euroasiatique et africaine vers l'Est.

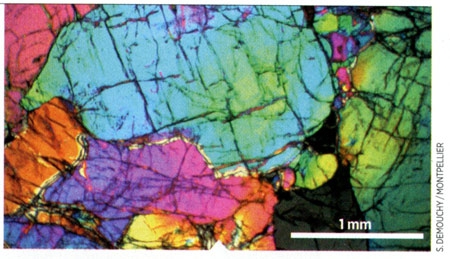

En fait, ce sont les anomalies de certaines roches qui rendent possible les mouvements de convection du manteau. Pour que l'immense manteau terrestre, fait entièrement de roches, se déplace de quelques centimètres par an (entre 2 et 9 cm) et permette le mouvement des plaques tectoniques, il faut impérativement qu'il existe de microscopiques aspérités entre les millions de grains composant les roches (image ci-dessous). C'est la surprenante conclusion d'une équipe conjointe de plusieurs universités françaises (Lille-I, Nancy, Metz, Montpellier), publiée dans la revue Nature en avril 2014.

Les aspérités entre les grains composant l'olivine donnent des propriétés de plasticité au manteau.

Cette « plasticité » du manteau était à ce jour une énigme. En effet, les propriétés physiques du minéral le plus abondant dans le manteau, l'olivine, empêchent théoriquement ces mouvements. Sa structure, très régulière et très ordonnée, est incompatible avec l'idée selon laquelle un matériau doit avoir des défauts (se traduisant par des faiblesses mécaniques) pour que son comportement soit plastique. Mais les scientifiques ont observé pour la première fois des défauts au niveau des joints de grains du minéral, appelés « désinclinaisons ». Et lorsqu'ils les ont intégrés dans la modélisation mathématique du comportement de la roche, ils ont conclu que ces défauts sont capables à eux seuls d'expliquer les mouvements dans le manteau.

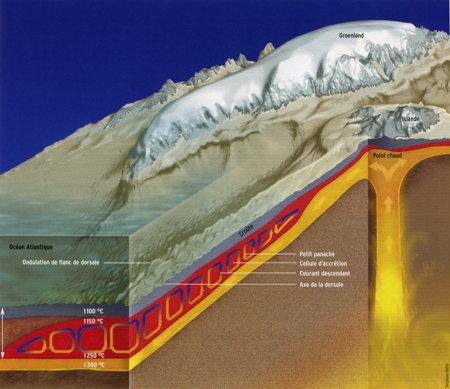

Dynamique de la dorsale médio-atlantique

(d'après Briais et all 2010)

LE MANTEAU SUPÉRIEUR (35 à 660 km ; 27% du volume de la terre)

À mesure que les pressions et les températures augmentent avec la profondeur, les éléments constitutifs du manteau s'arrangent en différentes structures cristallines (les minéraux) qui forment des couches distinctes. Trois minéraux, - l'olivine, la spinelle modifiée et la spinelle – donnent aux couches du manteau supérieur leur nom respectif.

LE MANTEAU INFÉRIEUR (660 à 2900 km ; 56% du volume de la terre)

Il est formé de deux couches : la pérovskite et la postpérovskite.

Couche de pérovskite. Le minéral qui domine cette couche (70% de la masse) est un silicate de magnésium appartenant à une famille de structures cristallines nommées pérovskites ou "(Mg,Fe)SiO3-pérovskite". C'est le matériau le plus abondant sur terre (38% de la masse du manteau et 70% de la masse du manteau inférieur) et connu depuis 2014 sous le nom de bridgmanite en hommage au minéralogiste Bridgmann. Existant à plus de 660 km de profondeur et sous des pressions énormes de l'ordre de 230 000 bars, la bridgmanite est inaccessible aux forages et hautement instable sous les conditions naturelles de surface. Ses propriétés physico-chimiques due à sa structure en feuillets déterminent une grande partie de la dynamique planétaire : les mouvements de convection qui la traversent sont à l'origine de la tectonique des plaques.

Couche de postpérovskite. Dans les conditions de pression et de température régnant dans les 300 derniers kilomètres du manteau avant le noyau, la pérovskite (1) se transforme en une nouvelle structure : la postpérovskite dont la structure cristalline est encore plus dense que celle de la pérovskite de 1 à 1,5 %.

(1) La pérovskite intéresse beaucoup les chercheurs en photovoltaïque. Il semble que l'avenir du solaire passera par la pérovskite. Ce minéral cristallin n'a révélé ses vertus énergétiques qu'en 2012. Mais depuis, il révolutionne le secteur. Ce matériau absorbe en effet la lumière dix fois mieux que le silicium qui équipe 85 % des panneaux solaires.

Son rendement énergétique, de 19 % en laboratoire, talonne son concurrent (à 26 %), mais il serait cinq fois moins cher à produire. Ce matériau devrait s'imposer dans le secteur des énergies renouvelables d'ici à la fin de la décennie. Et permettre d'accélérer la transition énergétique.

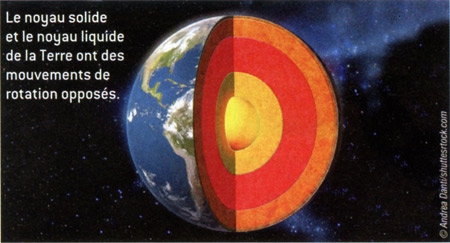

LE NOYAU (2900 à 6400 km ; 16% du volume de la terre)

Le noyau de la Terre est principalement composé de fer, liquide dans le noyau externe et solide dans le noyau interne (la graine, 0,5% du volume de la terre). Comme dans le manteau, la convection brasse le noyau externe, mais en raison de la densité beaucoup plus élevée du noyau, il y a très peu de mélange avec le manteau. Une couche plus dense s'intercale entre la base du manteau liquide et la graine. On pense que c'est la convection dans le noyau externe de fer liquide qui engendre le champ magnétique terrestre, lequel contribue à protéger la vie des rayons cosmiques et du vent solaire.

On peut se demander pourquoi la graine dont la température dépasse les 6000°C présente une structure solide. Ce phénomène est dû à la structure hexagonale compacte de ses molécules de fer comme l'ont démontré des géophysiciens suédois en 2017.

Mais quel est le processus qui explique le champ magnétique terrestre ? (Science & Vie, n° 1171, avril 2015 p. 26)

Longtemps on n'a pu expliquer ce phénomène. Et c'est tout récemment (2014) qu'une équipe américaine a proposé une hypothèse : en fait, le champ magnétique terrestre naîtrait des chocs d'électrons.

Si les physiciens ne parvenaient pas à reproduire la naissance du champ magnétique de la Terre, c'est parce qu'ils avaient sous-estimé la violence des chocs entre électrons. Ronald Cohen et son équipe de la Carnegie Institution de Washington (États-Unis) ont modélisé le comportement du fer à haute température au niveau atomique et se sont aperçus que les électrons ne cessent de s'éjecter les uns les autres, s'opposant à la formation d'un courant électrique... Dans le noyau terrestre, les électrons du fer fondu ralentissent ainsi les transferts de chaleur et provoquent la formation de mouvements de convection : des courants ascendants et descendants qui donnent naissance à un champ magnétique. Jusque-là, les modèles qui ne tenaient compte que des vibrations des atomes et des interactions moyennes des électrons ne parvenaient pas à former le moindre tourbillon de métal... et par conséquent, pas la moindre ligne de champ magnétique.

En fait, le fer du noyau remonterait dans le manteau comme semblent l'avoir montré (Nature, année 2012) par des expériences de laboratoire deux géophysiciens de l'université Yale (États-Unis). Ils ont réussi à montrer que la couche D" (prononcez « D seconde ») qui sépare, à 2900 km sous nos pieds, le manteau terrestre solide du noyau liquide et dont l'épaisseur serait inférieure à 200 km, ne serait pas totalement étanche : elle présenterait des remontées du noyau, des « blob » de fer liquide qui viendraient pénétrer les interstices de la roche sur 50 à 100 km.

Ces intrusions de fer pourraient jouer un rôle important dans les variations du champ magnétique terrestre. En effet, la présence de fer - métal conducteur d'électricité - influe sur la conductivité électrique du noyau, et ce sont les courants électriques du noyau qui alimentent et entretiennent le champ magnétique (voir plus haut l'ajout de mars 2015).

Pour parvenir à ce résultat rapporté par la revue Sciences et Avenir n° 792 (février 2013), les géophysiciens ont pris un cristal analogue à ceux que l'on suppose abondants dans le manteau de la Terre, à base de silicates de magnésium et de fer. Ils l'ont soumis à la pression et à la température qui règnent au niveau de la couche D" (135 gigapascals. Soit 1 350 000 fois la pression atmosphérique, et plus de 3200°C). Au bout de quelques minutes, les géophysiciens ont constaté la présence de bulles de fer liquides dans la roche solide (en médaillon). Les chercheurs supposent qu'il se passe la même chose à grande échelle dans la couche D".

Mouvements de convection au sein du globe terrestre

(d'après D. Sasselov & D. Valencia, Pour la Science, oct. 2010)

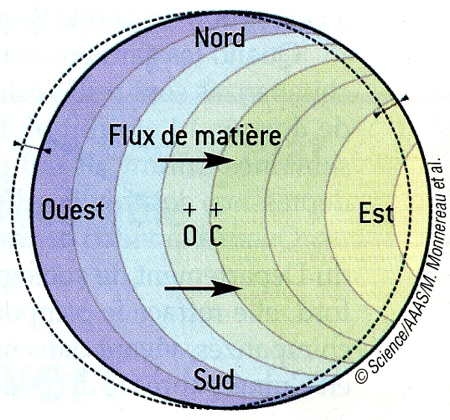

Chose étonnante, dans toutes ces sphères emboîtées et concentriques, la graine présente une structure asymétrique qu'on appelle la translation de la graine. Les couches superficielles de ses hémisphères "Ouest" (par convention sous l'Amérique) et "Est" (par convention sous l'Asie) n'ont pas les mêmes propriétés sismiques : les ondes sont plus lentes et moins atténuées à l'Ouest. Marc Monnereau & all. (Science, en ligne, 15 avril 2010) ont montré que cette dissymétrie était due à une différence de taille des cristaux de fer formant la graine, elle-même expliquée par un "vent de matière" orienté d'Ouest en Est.

L'hémisphère Ouest, froid et dense, décale vers lui le centre de masse de la graine. De ce fait, la rotation de celle-ci est décalée par rapport à son centre géométrique, et ses frontières Est et Ouest se décalent par rapport à la région sphérique (en pointillé sur la figure) où, étant donné la température et la pression, le fer est solide. Il en résulte une cristallisation du fer à l'Ouest, une fusion à l'Est et un déplacement progressif des couches de fer de l'Ouest vers l'Est. À mesure de ce déplacement, les cristaux de fer croissent en "absorbant" leurs voisins, pour atteindre une taille de cinq à dix kilomètres au niveau de la frontière Est. Arrivé à cette frontière, le fer fond et retourne au noyau liquide. Ainsi, la graine se renouvelle en continu. Reste à expliquer pourquoi l'hémisphère Ouest est froid et dense. Et à trancher avec d'autres modèles qui expliquent la dissymétrie des propriétés sismiques par un couplage thermique entre la graine et le manteau via le noyau liquide, ou par une interaction avec le champ magnétique de la Terre.

Ainsi, alors que son âge dépasse les 4,5 milliards d'années, la Terre renouvellerait son cœur en à peine 100 millions d'années.

La théorie de la translation de la graine expliquerait l'existence de la couche dense entre graine et base du noyau liquide, l'anisotropie élastique démontrée par le fait que les ondes sismiques voyagent plus vite dans la direction nord-sud que dans la direction ouest-est ainsi que l'asymétrie hémisphérique entre l'ouest et l'est. (voir également Science & Vie, nov. 2010).

En outre, la graine tourne à vitesse variable, de sorte que les battements du cœur de la Terre ne sont pas réguliers (Science & Vie, juillet 2013, p. 30).

Depuis les années 1990, les sismologues soupçonnent la "graine" de tourner sur elle-même plus vite que le reste du globe. Mais sans parvenir à s'accorder sur sa vitesse de rotation. Et pour cause : Hrvoje Tkalcic (université de Canberra, Australie) a découvert que cette vitesse n'est pas constante !

Pour l'affirmer, il a analysé des doublets de séismes, ces tremblements de terre "jumeaux" qui se produisent à des semaines ou des années d'intervalle, générant des ondes sismiques qui empruntennt le le même chemin au sein du globe. En étudiant les infimes différences de temps de parcours des ondes qui ont traversé la graine, le géophysicien en a conclu que la vitesse de rotation varie au cours du temps. Elle a accéléré dans les années 1970, ralenti dans les années 1980, puis repris da la vitesse dans les années 1990 et 2000.

La graine solide de la Terre tourne autour de son centre de masse (0), décalé par rapport à son centre géométrique (C). De ce fait, elle se décale par rapport au domaine où le fer devrait être solide (en pointillés). Cela crée une cristallisation à l'Ouest et une fusion à l'Est, et un flux de matière vers l'Est. Les couleurs représentent l'âge des couches (Pour la Science, n° 392, juin 2010).

La rotation du noyau terrestre enfin comprise ? (Pour la Science, n° 434, décembre 2013)

La Terre tourne sur elle-même vers l'Est en quasiment 24 heures. Il n'en va pas de même de son noyau. Le noyau interne (la graine), en fer solide, tourne dans le même sens, mais plus vite. Le noyau externe, constitué de fer liquide, tourne pour sa part en sens inverse, vers l'Ouest ! Philip Livermore, de l'Université de Leeds, en Grande-Bretagne, et ses collègues ont montré que ces mouvements du noyau sont liés et contrôlés par le champ magnétique terrestre.

La circulation du fer dans le noyau liquide engendre, par effet dynamo, le champ magnétique terrestre (de l'ordre de 10-4 tesla à la surface de la planète). Les géophysiciens ont observé depuis longtemps que ce champ se décale vers l'Ouest, ce qui suggère que le noyau liquide est animé d'un mouvement similaire. En outre, l'analyse de l'aimantation rémanente des roches montre que sur les 3 000 dernières années, le champ magnétique s'est déplacé vers l'Ouest à une vitesse variable, mais aussi vers l'Est. Rappelons qu'en se refroidissant après avoir été chauffées, certaines roches enregistrent l'orientation du moment magnétique : c'est l'aimantation rémanente.

L'étude des ondes sismiques qui se propagent dans tout le globe terrestre a par ailleurs révélé que le noyau interne (la graine) tourne vers l'Est et devance en moyenne le mouvement de la surface de la planète de quelques degrés par an.

P. Livermore et ses collègues se sont intéressés à l'interaction des composantes du noyau et du champ magnétique. Ils ont mis au point une simulation en trois dimensions du centre de la planète qui permet d'étudier des scénarios où la viscosité du fer liquide (qui n'est pas précisément connue) est 100 fois inférieure à celle des simulations précédentes. Cette viscosité joue un rôle crucial dans la dynamique du fluide ferreux et, par conséquent, sur l'effet dynamo et la structure du champ magnétique.

Avec leur simulation, les géologues ont ainsi mis en évidence que, dans des régimes de faible viscosité, certains couples de forces deviennent importants. Ces couples d'axe Nord-Sud agissent, les uns sur la partie la plus externe du noyau liquide, les autres dans le noyau solide. Ils ont la même intensité, mais des sens opposés. De quoi expliquer les mouvements opposés des noyaux interne et externe ?

P. W. Livermore et al., PNAS, en ligne, 16 septembre 2013

Ajout du 5 juin 2016 : Le noyau de la terre est plus jeune que sa surface (Sciences et Avenir n° 832, juin 2016, p. 56.)

En appliquant la relativité générale à l'intérieur de la Terre, une équipe danoise a conclut que son cœur serait plus jeune que sa surface de deux ans et demi. Une conclusion publiée dans l'édition de mai 2016 de l'European Journal of Physics. Mais comment imaginer que l'intérieur de la Terre se soit formé quelque temps après la croûte, sur laquelle nous marchons ?

Ce paradoxe s'explique par la théorie de la relativité générale qui veut qu'à proximité d'une masse très dense comme la graine de la Terre, le temps s'écoule plus lentement. Il s'agit en fait d'un paradoxe connu de longue date. Richard Feynman — lauréat du prix Nobel de physique en 1965 et décédé en 1988 —, l'enseignait déjà. Mais Feynman avait estimé la différence d'âge entre superficie et profondeur à un jour ou deux. Le calcul de l'équipe danoise montre un écart bien plus important. En fait, ce paradoxe ne remet aucunement en question les connaissances des géophysiciens sur la formation de la Terre, une planète dont l'âge est estimé aujourd'hui à 4,56 milliards d'années, et qui a grossi progressivement par accrétion — c'est-à-dire grâce à l'agglomération de grains de matière. Mais en revanche, si l'on tient compte des conséquences étonnantes de la relativité générale d'Einstein, il faut considérer que la masse modifie l'espace et le temps.

La densité des roches s'accroît avec la profondeur

À proximité d'une masse importante comme un astre dense, l'espace se courbe, un peu comme si, en deux dimensions, un tissu élastique se tend sous le poids d'une boule de métal. Quant au temps, il s'écoule plus lentement. Or, les géophysiciens ne cessent d'améliorer leur modèle de l'intérieur de la Terre. Ils savent que la densité des roches augmente avec la profondeur. La matière y présente un arrangement compact que l'on ne rencontre pas en surface. Ainsi, la graine, cette sphère centrale très dense de 1200 km de rayon, développe un champ de gravité important. Près de la graine, le temps devrait donc s'écouler plus lentement. La relativité générale n'ayant jamais été prise en défaut, si une horloge était placée à la profondeur de la graine, elle marquerait moins de secondes au cours du même laps de temps qu'une horloge placée à la surface. Et c'est ainsi que l'on parvient à estimer l'intérieur de la Terre plus jeune que sa surface. Même si en pratique, deux ans et demi ne sont pas significatif par rapport à l'âge de la planète.

Quant à l'écart entre ce qu'enseignait Richard Feynman et ce qu'ont découvert les Danois, il s'explique par le fait que ces derniers ont rigoureusement utilisé le dernier modèle de l'intérieur de la Terre où la densité de matière n'est pas homogène à une même profondeur.

Il y a de la vie dans les profondeurs (Sciences et Avenir, août 2016, p. 33)

Des chercheurs français et italiens ont mis en évidence pour la première fois, en 2012, l'existence d'une vie intra-terrestre le long de la ride médio-atlantique : ces roches de la croûte terrestre se sont révélé abriter une vie diverse et active, qui pourrait bien représenter l'habitat microbien le plus important de notre planète ! La lithosphère, poreuse et fracturée, est affectée par d'intenses circulations hydrothermales, soit un environnement semblable à celui de notre Terre il y a plus de 3,8 milliards d'années. Les bactéries pourraient être des descendants des premières formes de vie terrestre.

20:00 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : structure de la terre, géologie, croûte océanique, manteau, volcanisme, tectonique des plaques, subduction, dorsale médio-atlantique, bridgmanite, mouvements de convection du manteau, désinclinaisons des joints de grains du minéral, pérovskite, postpérovskite, graine terrestre, champ magnétique terrestre, translation de la graine, vent de matière, vie dans les profondeurs | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

Le volcanisme dans l'Arc antillais (1)

Rappels de la structure du globe terrestre. Différents types de volcans et d'éruption.

19:26 Publié dans Volcanologie-Sismologie | Tags : volcanisme, arc antillais, subduction, dorsale, points chauds | Lien permanent | Commentaires (1) | ![]() Facebook | | |

Facebook | | |

Roches volcaniques de l'Arc antillais

Roches volcaniques dans l'Arc antillais

12:49 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : antilles, volcanisme, martinique, guadeloupe, arc antillais, pétrographie, minéralogie | Lien permanent | Commentaires (6) | ![]() Facebook | | |

Facebook | | |

La Soufrière de Guadeloupe

La Soufrière de Guadeloupe avant, pendant et après l'éruption phréatique de 1976

10:26 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : arc antillais, volcanisme, éruption volcanique, éruption phréatique, soufrière de guadeloupe | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

La Soufrière de Guadeloupe : séismes 1975-1977

Séismes associés à l'éruption phréatique de la Soufrière de Guadeloupe de 1976

10:00 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : soufrière de guadeloupe, feuillard, séisme, volcanisme, lahars, éruption phréatique, éruption volcanique, antilles, arc antillais | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

01/07/2010

La Montagne Pelée (Martinique)

La Montagne Pelée (Martinique) et l'éruption catastrophique de 1902

11:38 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : volcanisme, arc antillais, martinique, montagne pelée | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

28/06/2010

La Soufrière de Saint-Vincent

La Soufrière de Saint-Vincent et l'éruption de 1979

17:44 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : arc antillais, antilles, caraïbe, volcanisme, saint-vincent | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

Soufrière à Sainte-Lucie

Manifestations volcaniques de Sainte-Lucie et de la Dominique

08:05 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : volcanisme, arc antillais, antilles, dominique, sainte-lucie | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

25/06/2010

La Soufrière de Montserrat

La Soufrière de Monserrat et les éruptions successives de 1995 à 2010

21:03 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : volcanisme, arc antillais, montserrat, éruption volcanique | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

24/06/2010

Islande : geysers et autres manifestations volcaniques

Geysers, fumerolles, solfatares, hordinos et mares de boue d'Islande

Geysers, fumerolles, solfatares, hordinos et mares de boue d'Islande

par André Guyard

(dernière mise à jour : 20 novembre 2015)

En juillet 2008, un groupe de randonneurs appartenant à l'USN Sports Loisirs a parcouru les paysages désolés de l'Islande à la découverte de phénomènes volcaniques actifs.

Le groupe va découvrir un univers de glace, d'eau et de feu.

Orgues basaltiques

Cliché Orsolya & Erlend Haarberg

Mais comment se forment les orgues basaltiques ?

Il s'agit, bien sûr, d'une conséquence du refroidissement d'anciennes coulées de lave. En 2015, Martin Hofmann, de l'université technique de Dresde, en Allemagne, et ses collègues ont modélisé la formation de tels motifs hexagonaux qu'on appelle orgues basaltiques.

Lorsque de la lave se refroidit ou lorsque de la boue sèche, la partie supérieure se contracte et se fissure, ce qui libère de l'énergie liée à la tension mécanique. Ces failles sont disposées, a priori, de façon aléatoire. Cependant, comme elles libèrent surtout la tension perpendiculaire à leur direction, elles se connectent en général à angle droit : on parle de jonction T.

Dans des milieux qui sont asséchés ou gelés périodiquement, on observe que les jonctions T se déforment et se déplacent, ce qui les transforme en jonctions Y aux angles de 120°. Les motifs hexagonaux en résultent.

Dans le basalte, des jonctions T se forment en surface, mais la transition entre jonctions T et Y se produit en profondeur, alors que les fractures se propagent dans la lave se refroidissant.

Martin Hofmann et ses collègues ont calculé l'énergie libérée lorsqu'une fracture se propage. Ils ont supposé que la forme des jonctions pouvait changer. Ils montrent ainsi que si la jonction se déforme de T vers Y, l'énergie libérée augmente de 7%. La tension dans le basalte est ainsi mieux dissipée et la configuration plus stable. Des simulations numériques ont confirmé les résultats des chercheurs.

Phys. Rev. Lett., vol. 115, 154301, 2015

Parmi les différentes manifestations volcaniques rencontrées : fumerolles, solfatares, sources chaudes, hordinos, mares de boue, etc. les plus spectaculaires sont certainement le fait des geysers.

Qu'est-ce qu'un geyser ?

Un geyser est une source qui jaillit par intermittence en projetant de l'eau chaude et de la vapeur à haute température. Le terme geyser provient de Geysir, le nom du plus célèbre geyser islandais, dont l'étymologie est liée au verbe islandais gjósa (en français jaillir).

Or le grand geyser de Geysir ne fonctionne plus de façon naturelle. Seuls des visiteurs illustres ont droit à sa manifestation dopée par l'usage de détergents précipités dans le conduit. Mais les touristes ordinaires peuvent admirer son voisin le Strokkur qui se manifeste toutes les 8-10 min.

Comment ça marche ?

L'activité des geysers, comme celle de toutes les sources chaudes, est liée à une infiltration d'eau en profondeur.

Dans les régions volcaniques, l'eau est chauffée au contact des roches, elles-mêmes chauffées par le magma en fusion.

Dans les régions non volcaniques, l'eau est chauffée par l'action du gradient géothermique, la température et la pression augmentant avec la profondeur.

Par convection, l'eau chauffée et mise sous pression rejaillit alors vers la surface. Les geysers diffèrent des simples sources chaudes par la structure géologique souterraine. L'orifice de surface est généralement étroit communiquant par des conduits étroits et résistants qui mènent à d'imposants réservoirs d'eau souterrains.

L'eau de surface s'infiltre par gravité dans le réservoir du geyser où elle s'accumule et monte dans le conduit. La pression dépend de la longueur de la cheminée. Plus la pression est grande, plus la température d'ébullition est élevée. L'eau du conduit va faire pression sur l'eau du réservoir et augmentera la température d'ébullition. Au bout d'un certain temps, la poche magmatique sera portée à une température suffisante pour entraîner la vaporisation d'une partie de l'eau et créant ainsi une bulle de vapeur. Cette bulle emprunte la seule issue qui lui est offerte : la cheminée où elle s'engouffre, refoulant vers le haut l'eau du conduit qui n'exercera plus de pression sur l'eau du réservoir. Cette dernière va entrer en ébullition et pousser toute l'eau du geyser à l'extérieur.

La bulle est prête à éclater

Le Strokkur en pleine action

En fait, il existe deux types de geysers. Le geyser dit « fontaine » est terminé par un cône étroit, avec un conduit très fin. Lorsqu'une éruption se produit et qu'une colonne d'eau jaillit, elle est en fait expulsée par la pression due à l'étroitesse du conduit. C'est le cas par exemple d'Old Faithful à Yellostone.

L'autre type de geyser est le geyser dit « gazeux ». Il s'agit généralement d'une source chaude qui, lorsque du gaz est expulsé, fait remonter les bulles d'eau qui explosent au contact de la surface et qui créent une large colonne d'eau, souvent de courte durée. C'est le cas du Strokkur que nous avons pu observer ici.

Fumerolles et solfatares

Les fumerolles sont des émanations de gaz, en particulier de la vapeur d'eau ou de dioxyde de carbone qui s'échappent de crevasses ou de cavités d'origine volcanique.

Les solfatares sont des fumerolles rejetant du soufre.

Mares de boues

Une mare de boue est un type de source d'eau chaude ou de fumerolle, brassant des sédiments (argile d'origine volcanique, oxyde de fer, soufre...) à sa surface, et caractérisée par de perpétuelles remontées de bulles de gaz à sa surface.

Mofettes

Les mofettes sont de petites émanations de dioxyde de carbone qui s'échappent de fissures et des trous d'origine volcaniques d'où s'échappe du gaz carbonique. Parfois, les mofettes brassent des sédiments à leur surface.

Hornitos

Les hornitos sont des cônes volcaniques de dégazage, créés lors de retombées de fragments de laves incandescents entre eux.

Ces différents phénomènes sont visibles sur la vidéo ci-dessous :

Phénomènes volcaniques

Les Islandais ont su profiter de toute cette chaleur interne et exploitent cette source d'énergie pour procurer aux habitants de l'eau chaude, alimenter des serres avec production de fleurs, de légumes et de fruits. Eh, oui ! il pousse des bananiers en Islande. D'une façon plus importante, la géothermie permet la génération d'électricité pour les industries métallurgiques et la consommation domestique.

Centrale géothermique du volcan Krafla

(© Schutterstock/Darren Baker)

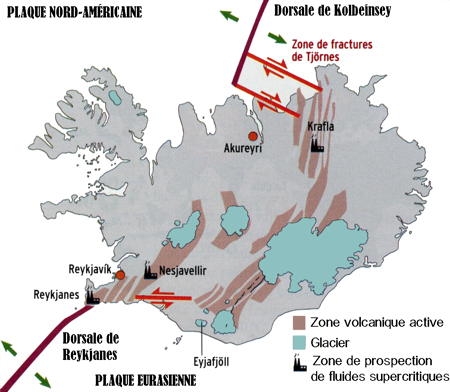

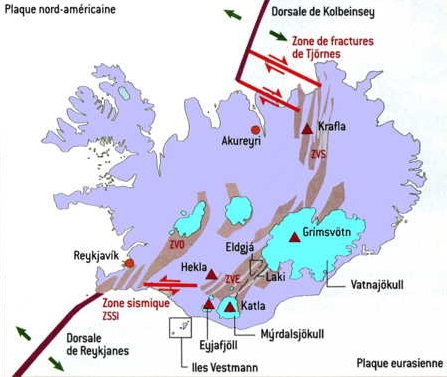

L'Islande est située à l'extrémité nord de la dorsale médio-atlantique qui court sur 15 000 km au milieu du plancher de l'océan Atlantique et dont l'île constitue la seule partie émergée. Le long des dorsales océaniques, deux plaques tectoniques s'écartent et le manteau terrestre sous-jacent va se figer pour former une jeune croûte océanique, la lithosphère. La dorsale médio-atlantique forme ainsi une chaîne continue de volcans sous-marins émettant une lave visqueuse (plus riche en silice) de type andésite. Ainsi l'Islande est déchirée par la séparation des deux plaques : la plaque nord-américaine qui s'éloigne vers l'ouest et la plaque eurasienne qui s'éloigne vers l'est à la vitesse de 2 cm par an.

À ce phénomène de l'écartement des deux plaques océaniques, un point chaud s'y superpose.

Un point chaud est marqué par la remontée d'un panache volcanique issu de la base du manteau inférieur, c'est-à-dire à près de 2900 km. La lave des volcans de point chaud est très fluide et formée de basalte (pauvre en silice). Ces points chauds sont fixes et indépendants du mouvement des plaques. Et, au fur et à mesure de l'avancée de la plaque tectonique océanique, celle-ci est perforée par un nouveau volcan à l'aplomb du panache volcanique.

L'Islande résulte ainsi de la superposition de ces laves andésitiques ou basaltiques. Pas moins de 130 volcans coexistent en Islande, dont certains sont recouverrts par des glaciers (volcans sous-glaciaires).

13:48 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Tags : geyser, islande, volcanisme, solfatares, hordinos, orgues basaltiques | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

23/06/2010

Éruption du volcan islandais Eyjafjöll

Éruption du volcan islandais Eyjafjöll

Éruption du volcan islandais Eyjafjöll

par André Guyard

(dernière mise à jour 23/08/2014)

L'Islande est située au milieu de l'Atlantique sur la dorsale médio-océanique, à la divergence des plaques tectoniques océaniques eurasiatique et américaine. Cette situation exceptionnelle en fait l'une des régions tectoniques les plus actives du monde avec 130 volcans et 600 sources d'eaux chaudes ! L'île se situe aussi au niveau d'un point chaud qui émerge entre deux plaques tectoniques. Ainsi, elle se trouve soumise à deux influences volcaniques superposées. (voir dans ce même blog : Islande, geysers et autres manifestations volcaniques.)

Qu'est-ce qu'un point chaud ? Il s'agit d'une anomalie thermique située dans les profondeurs du manteau terrestre, qui fait remonter du magma en surface. C'est ce qu'on appelle le panache profond dans le cas de l'Islande de 2900 km et qui remonte en surface déchirant la croûte terrestre. L'originalité du cas islandais, c'est que cette déchirure se produit justement là où les deux plaques nord-américaine et eurasiatique s'écartent au niveau de la dorsale médio-atlantique.

En juillet 2008, j'ai eu l'occasion d'arpenter ce beau pays avec les randonneurs de l'US Novillars : voir Islande, geysers et autres manifestations volcaniques dans ce même blog.

Profitant de la présence de ce chauffage central naturel, l'Islande exploite ses ressources géothermiques pour produire son électricité et alimenter son réseau de chaleur. Mais le volcanisme a souvent un revers : une nouvelle éruption fissurale à proximité du glacier Eyjafjallajökull inquiète les volcanologues.

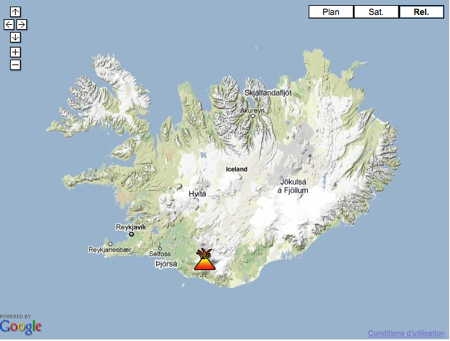

(cliché Google Earth)

Le volcan islandais Eyjafjöll (ou Eyafjalla) situé dans le sud de l'île, à seulement 160 km au sud-est de la capitale Reykjavik est un strato-volcan composé d'un empilement d'une alternance de couches de cendres, de lave et de roches éjectées par les éruptions antérieures. Il est entré en éruption dans la nuit du samedi 20 mars 2010. Recouvert par une calotte glaciaire : l'Eyjafjallajökull, ce volcan culmine à 1 666 mètres d'altitude. Au cours des 1100 dernières années, le volcan ne s'est réveillé que trois fois, la dernière éruption de l'Eyjafjöll remontant à 1821. Elle avait alors duré plus d'un an.

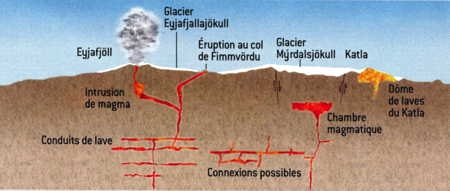

Précédée par toute une série de secousses sismiques sous le glacier Eyjafjallajökull, (près de 3000 entre le 3 et le 5 mars), la première phase éruptive fut effusive avec une lave de basalte à olivine d'origine profonde (25 km). Après un arrêt temporaire de la migration du magma vers 6 à 8 km de profondeur, le magma a émergé par une dizaine de fontaines de lave de style hawaïen, d'une hauteur d'une centaine de mètres, le long d'une fissure latérale au col de Fimmvördu.

Le volcan est entré le 14 avril dans une deuxième phase explosive caractérisée cette fois par un magma acide, de type trachyandésitique résultant d'un mélange de basalte à olivine et de dacites plus superficielles. Ce mélange serait ensuite remonté dans le cratère historique de l'Eyjafjöll. Le contact de la lave à plus de 1000 °C et de la glace a provoqué des explosions et l'émission jusquà 11 000 m d'altitude d'immenses volutes de vapeur d'eau et de gaz chargés de poussières magmatiques. qu'on appelle téphras. C'est la confluence de deux anticyclones, l'un positionné entre Terre Neuve et l'Islande et l'autre localisé sur l'Europe occidentale qui a entraîné lles masses d'air dans le sens des aiguilles d'une montre. Poussé par ces vents, le panache s'est dirigé vers l'Europe.

Le caractère explosif d'un volcan est lié au dégazage et à la viscosité du magma trachyandésitique. Quand le magma monte dans le cheminée du volcan, le mélange de gaz et de magma se dilate, ce qui accélère son ascension, accroît la pression jusqu'à faire passer l'éruption en régime explosif. Dans le cas de l'Eyjafjöll, les explosions sont dues à la fois à la nature acide du magma que la présence de silice rend visqueux et au contact magma-glace.

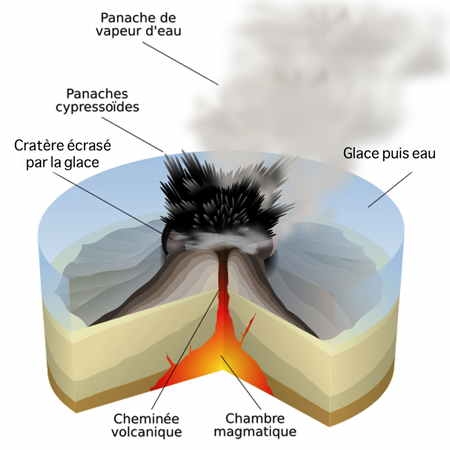

Schéma de l'éruption d'un volcan sous-glaciaire

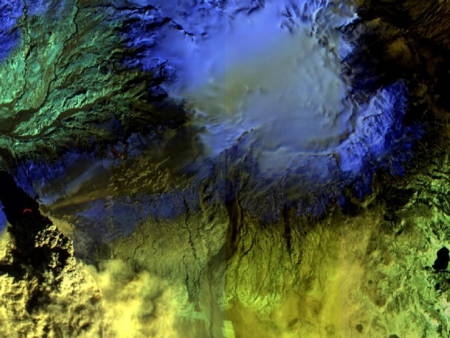

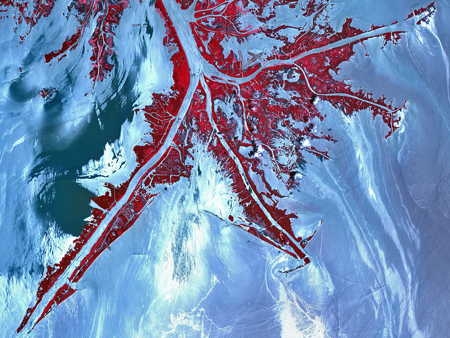

Le samedi 17 avril 2010 , l'instrument ALI du satellite EO-1 a pris une image infrarouge du glacier islandais Eyjafjallajökull qui cache le volcan (image ci-dessus). Un léger nuage surmonte le glacier.

Les cendres émises se mêlent à la vapeur d'eau

Soumise à une pluie de cendres et de bombes,

la surface du glacier a changé de couleur

Afin de protéger les populations, 600 personnes demeurant entre la localité agricole de Hvolsvollur et le village de pêcheurs de Vik ont été évacuées hâtivement.

Quelques villages sont menacés

Les risques encourus sont multiples :

* projections de cendres et de lave pouvant affecter notamment le transport aérien (voir plus bas),

* émanations gazeuses mortelles (notamment pour le bétail),

* inondations brutales et importantes, conséquence de la fonte du glacier qui recouvre le volcan.

Ce dernier risque, de loin le plus inquiétant, est un lahar ou jökulhlaup en islandais, ce qui signifie "course de glacier". La fonte du glacier sous l'effet de la chaleur engendre une coulée de matériaux volcaniques (débris, boue). On parle alors de lahars syno-éruptifs appelés aussi lahars primaires ou lahars chauds. On se rappelle que la formation d'un lahar suite à l'éruption du volcan Nevado del Ruiz en 1985 dans la Cordillère des Andes avait entraîné la mort de 25 000 personnes. C'est pourquoi, un état d'urgence a été déclaré dans la zone, même si aucun blessé ou dégât n'est à déplorer.

Le nuage de cendres

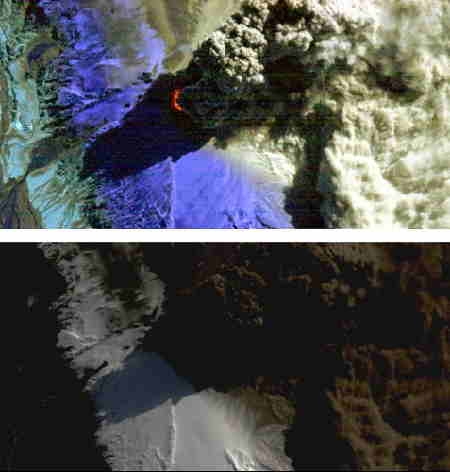

Photos du volcan Eyjafjöll prise le samedi 17 avril 2010

En haut, une photo en infrarouge.

En bas, une photo du volcan tel qu'il est visible depuis le ciel.

(Crédit photo : © Nasa)

On distingue sur ces clichés le nuage de cendres, au centre, la neige des glaciers (en blanc en bas et en violet en haut) ainsi que les dépôts de cendres, visibles en gris en haut. Ces cendres sont chargées électriquement, ce qui entraînent la formation de nombreux éclairs au-dessus du volcan.

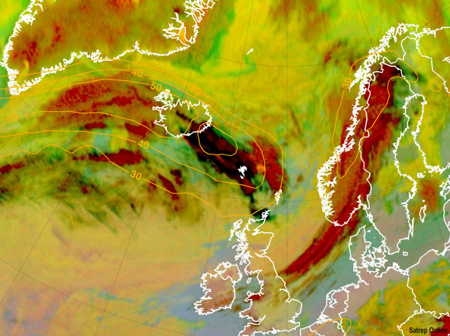

Mais ce qui inquiète les Européens, c'est ce nuage de cendres volcaniques, poussé par les vents d'Ouest qui se répand sur l'Europe entraînant la suspension des vols à partir et en direction de nombreux aéroports.

Le réveil du volcan Katla suscite l'inquiétude

Pour le moment, les volcanologues sont prudents car cette petite éruption fissurale, qui ne montre aucun signe d'affaiblissement, pourrait déclencher celle du volcan voisin, le Katla. Dix fois plus important que l'Eyjafjöll, il a la réputation d'être un des volcans les plus dangereux d'Islande. Caché sous le glacier Myrdalsjökull dans le Sud de l'île, le Katla est entré pour la dernière fois en éruption en 1918. Une éruption du volcan Katla et le contact du magma avec la glace déclencherait une éruption explosive qui émettrait un énorme nuage de cendres et surtout une débâcle glaciaire, c'est-à-dire un gigantesque lahar. Ce déferlement d'eau, de glace et de boue représente un risque majeur car une population relativement dense vit à ses pieds.

Comment les cendres volcaniques menacent les aéronefs

Parce que les nuages de cendres sont secs, ils sont invisibles sur les radars météorologiques.

Pour comprendre le risque, rappelons-nous de la mésaventure d'un Boeing 747 de la British Airways survenue le 24 juin 1982. Le Boeing 747 avait décollé de Londres pour Auckland (Nouvelle-Zélande). L'équipage ignorait que le volcan Mount Galunggung à l'ouest de Java (Indonésie) était entré en éruption et crachait des cendres à son altitude de vol.

Quelque part au sud de Java à 1 h 40, heure locale, l'équipage remarqua que le verre des fenêtres du poste de pilotage devenait brillant, phénomène aussitôt suivi par une lueur au niveau des moteurs et une odeur de gaz sulfureux envahissant la cabine. En quelques minutes, les quatre moteurs furent coupés et le jumbo-jet dut parcourir en planeur 11 kilomètres au-dessus de l'océan. À l'altitude de 4 kilomètres, cependant, certains des moteurs purent être remis en marche et l'avion atterrit en toute sécurité à Jakarta.

Comme nous l'avons dit plus haut, les cendres volcaniques ou téphras se composent de particules de roche pulvérisée vitreuse de diamètre inférieur à 2 millimètres et extrêmement corrosives. Quand un avion vole en altitude à sa vitesse de croisière, les fenêtres du poste de pilotage subissent un jet de téphras, obscurcissant la vue des pilotes. Les moteurs aspirent la poussière qui fond dans la chambre de combustion et ce magma se dépose sur les aubes de turbine bloquant ainsi le flux d'air du moteur, s'immisçant également dans les tubulures. Heureusement quand le magma se refroidit et se solidifie alors que l'avion plonge en planeur, il arrive qu'il se détache et permette un redémarrage du moteur.

En outre, le nuage chargé de cendres est appauvri en oxygène. Si un aéronef le traverse, la combustion du kérosène s'en trouve gênée et le rendement des réacteurs minoré pouvant aller jusqu'à l'extinction.

En ce qui concerne le Eyjafjöll, tant que le risque lié au nuage de cendres volcaniques a subsisté, les transports aériens de l'Europe du Nord, y compris la moitié nord de la France et la Suisse ont été suspendus.

Remarque (11/06/2011) : une décision justifiée par des études en laboratoire

En fait, la décision de bloquer au sol les avions pendant l'éruption du volcan islandais était la bonne, affirme le département de chimie de l'université de Copenhague (Danemark). Les cendres émises pouvaient bel et bien perturber les moteurs, selon les essais réalisés en laboratoire.

Une étude publiée dans les Pnas a montré que les cendres de l'Eyjafjoll étaient abrasives et le sont restées durant plusieurs semaines. D'une taille variant d'une dizaine de nanomètres au millimètre près du volcan, les particules, associées à de la vapeur d'eau, étaient composées d'andésite, de cristaux de plagioclases (silicates), de pyroxènes et d'olivine. Les risques pour les avions étaient multiples : abrasion du pare-brise, vitrification sur certaines parties des réacteurs.

Les chercheurs annoncent par ailleurs dans les Pnas avoir mis au point une méthode pour déterminer en 24 heures la dangerosité des cendres.

Remarque (24/05/2011) : Peut-on protéger les avions des cendres volcaniques ?

L'éruption de l'Eyjafjöll, en avril 2010, a projeté dans l'atmosphère une grande quantité de cendres, ce qui a paralysé le trafic aérien en Europe. Un peu plus d'un an après, un autre volcan sous-glaciaire islandais, le Grimsvötn, est entré en éruption projetant également un panache de cendres qui a atteint 20.000 mètres de hauteur le samedi 21 mai 2011, premier jour de l'éruption.

En quelques, jour, le panache de cendres dégagé par le Grimsvötn s'est réduit aux alentours de 2000 mètres de hauteur et l'éruption pourrait prendre fin avant la fin du mois de mai.

Le trafic aérien a été perturbé en Islande et dans les Îles britanniques.

Le risque couru par les aéronefs est dû au fait que les cendres sont susceptibles de fondre dans les réacteurs des avions, et dégradent les céramiques isolantes.

La céramique utilisée en aéronautique est composée d'un mélange d'oxydes de zirconium (ZrO2) et d'yttrium (Y2O3) ; elle isole le réacteur des pièces situées à proximité. Sa structure poreuse la rend flexible : elle peut se déformer sans se rompre lors des changements de température.

Nitin Padture, de l'Université de l'Ohio et ses collègues américains et russes ont étudié son comportement quand elle est chauffée à 1200 °C en présence des cendres, riches en silice, prélevées sur l'Eyjafjöll. Ils ont montré que les cendres fondent et constituent une phase vitreuse peu visqueuse qui pénètre dans les pores. En refroidissant, la silice durcit, diminuant la flexibilité de la céramique, qui risque de se détacher du réacteur. Les chercheurs ont mis au point une nouvelle céramique d'oxyde de zirconium et de gadolinium (Gd2Zr2O7), imperméable aux cendres fondues dès que son épaisseur est supérieure à dix micromètres. À haute température, cette céramique réagit partiellement avec les cendres et forme de petits cristaux qui colmatent l'entrée des pores. Ainsi, la silice vitreuse ne pénètre plus profondément dans la céramique, et le matériau conserve à peu près sa structure et ses propriétés isolantes.

Ces nouveaux matériaux doivent encore subir des tests pour que l'on sache s'ils conservent leurs propriétés après plusieurs cycles d'élévation de la température. Les avions devraient pouvoir alors voler à travers des nuages de cendres volcaniques.

Source : J. Drexler et al., Advanced Materials, en ligne, 8 avril 2011

Le système AVOID (6 novembre 2013)

Grâce à ce système mis au point par des chercheurs norvégiens, les avions ne seront plus bloqués par les volcans. Pour éviter que les avions restent cloués au sol par les panaches de cendres, des chercheurs norvégiens associés à une compagnie aérienne ont développé le système AVOID. Ce système va permettre aux avions de déceler ces infimes particules à une centaine de kilomètres de distance. Assez loin pour pouvoir adapter leur plan de vol ! Son efficacité a été testée avec succès en octobre 2013. Ce dispositif exploite la loi de Planck, qui lie la température d'un corps à son rayonnement : un nuage de cendres étant plus chaud qu'un cumulonimbus, par exemple, il n'émet pas les mêmes ondes, ce qui permet de le repérer. Captées à l'aide de deux caméras thermiques à infrarouge fixées sur l'avion, les données sont transmises en temps réel à l'ordinateur de bord ainsi qu'au centre de contrôle aérien. Des cartes de dispersion des cendres sont ainsi établies. Encore au stade de développement, le système intéresse déjà de nombreuses compagnies aériennes. Easy Jet envisage de l'intégrer dès 2015 sur une dizaine d'appareils.

Surveillance des panaches de cendres volcaniques (octobre 2011)

L'éruption de l'Eyjafjoll a entraîné une longue et très coûteuse fermeture de l'espace aérien. Pour éviter que cette situation de crise ne se reproduise, experts, chercheurs et météorologues des VAAC (Volcanic Ashes Advisory Centers) unissent désormais davantage leurs efforts et leurs moyens pour prédire l'avancée des panaches de cendres. En combinant étude directe et détection par satellites, photomètres et lidars (télédétection par laser), parfois transformés pour l'occasion, ils cumulent des informations sur la composition, l'altitude ou la densité des cendres et obtiennent en quelques heures des cartes prévisionnelles fiables du trajet de ces nuages afin de renseigner au plus vite les compagnies aériennes. Un travail qui reste cependant difficile compte tenu des incertitudes naturelles (caprices du volcan, conditions météorologiques, etc.) mais aussi en raison de l'absence d'un réseau d'observation européen spécifique.

1. Par une étude directe

Échantillonnage des cendres au sol ou dans le nuage, par avion (ATR 42 M55 Geophysica) pour connaître leurs propriétés microphysiques (granulométrie, forme...) et leur composition chimique.

2. Au sol

Surveillance de l'atmosphère via des réseaux de radars, lidars, interféromètres, photomètres... Ces derniers mesurent l'intensité de la lumière qui leur parvient du Soleil, plus basse en présence de cendres, permettant d'évaluer l'épaisseur du nuage. Ces mesures sont rendues difficiles en présence de pollution.

3. Par satellites

Utilisation de radiomètres, interféromètres, lidars, etc., embarqués dans des satellites d'observation de l'atmosphère (Parasol, Calipso, Météosat, Envisat, Metop, Terra, Aqua...) pour déterminer la surface, l'altitude, l'épaisseur du nuage et certaines de ses caractéristiques.

4. Par avion

16 avril 2010 : le CEA à Saclay détecte des cendres de l'Eyjafjoll au nord de la France puis à 6 km au-dessus de Paris. Afin de pouvoir renseigner les compagnies aériennes, il embarque un lidar dans un avion Falcon 20 de l'unité Satire (CNRS, Cnes, Météo-France). Cet appareil, aussi utilisé au sol ou par satellite, émet un faisceau laser vers l'atmosphère et analyse la lumière qui lui revient. En dépolarisant cette lumière, les cendres signent leur présence dans l'atmophère.

Source : Marion Sabourdy, Sciences et Avenir, n° 776, octobre 2011, p. 16-17.

Destin des cendres

Que vont devenir ces cendres ? Soumises aux pluies et aux vents, elles ont rejoint les couches basses de la troposphère et se sont fondus dans la masse des polluants urbains et industriels.

À la suite de l'éruption de l'Eyjafjöll, un groupe de travail international dirigé par l'Autorité de l'Aviation Civile (CAA) du Royaume-Uni a défini trois zones pour le trafic aérien.

- Zone 1, moins de 0,2 mg de cendres par m3 d'aire : aucune restriction de vol.

- Zone 2, concentration comprise entre 0,2 et 2 mg par m3 d'air : les vols sont possibles, mais les contrôles de maintenance et d'inspection des appareils sont renforcés.

- Zone 3 : concentration supérieure à 2 m par m3 d'air : les vols sont interdits.

Selon la météo, des vols de durée limitée peuvent cependant être autorisés jusqu'à 4 mg par la CAA.

Comment la vie peut reprendre le dessus

Ce problème rejoint celui des biotopes soumis aux incendies. Après incendie ou éruption volcanique, la biodiversité se recompose grâce aux espèces opportunistes. Sur la terre carbonisée, les quelques espèces survivantes, mais surtout celles qui vivaient en lisière profitent de la situation pour recoloniser le milieu. Et cela rapidement. L'ampleur et la rapidité de la recolonisation dépendent de l'intensité de la brûlure, du lieu et du moment de la catastrophe, ainsi que des espèces présentes sur et autour du site anéanti.