29/12/2013

Décès de Robert Barbault le 12 décembre 2013

Sauf dans les milieux scientifiques, on n'a pas beaucoup parlé de la mort de Robert Barbault survenue le 12 décembre 2013 après un cancer du colon. J'ai largement puisé dans ses ouvrages d'écologie générale et d'écologie des populations et des peuplements pour apprécier sa pédagogie.

Je laisse le soin à Gilles Bœuf et à Denis Couvet, respectivement président et professeur au Muséum national d'histoire naturelle de retracer les grandes étapes de sa carrière scientifique.

Robert Barbault est né le 24 janvier 1943. Étudiant en 1964 au laboratoire de zoologie du professeur Lamotte à l’École Normale Supérieure de Paris, alors située rue Lhomond, il fut attiré au début par l’éthologie. Il passait rapidement à l’écologie sous la direction des professeurs Lamotte et Bourlière et partait pour une mission de longue durée « sur le terrain » à la station d’écologie tropicale dans la savane de Lamto en Côte d’Ivoire. Il va y travailler sur les réseaux trophiques et les stratégies biodémographiques des populations de reptiles et amphibiens. De façon permanente et durant toute sa vie, son humanisme et ses préoccupations constantes l’ont toujours amené à relier l’humain à cette nature qui nous entoure et à laquelle il appartient pleinement, ainsi qu’il l’avait fait au tout début en s’interrogeant au regard que portaient les populations locales, les Baoulés, sur les activités de cette station de recherche en Afrique. Il s’intéressait aussi à d’autres formes de pensées et d’inscription de l’humain dans le vivant et dans l’univers. Il avait lu et médité les grands penseurs indiens et était allé en Inde. Il défendra son doctorat d’État en 1973.

Robert aura ensuite des responsabilités scientifiques croissantes et majeures pour la communauté des écologues. Il a construit des équipes de recherche, des laboratoires, des programmes nationaux et internationaux, dans le domaine de la biologie des populations et des peuplements dans un premier temps, puis dans le domaine plus vaste de l’écologie et de la biodiversité. Il a assumé de très nombreuses et lourdes responsabilités scientifiques, au CNRS, -animateur du secteur écologie-évolution-environnement, directeur-scientifique, président de la section d’écologie, à l’Université Pierre & Marie Curie où il organisait le laboratoire d’écologie puis au Muséum national d’Histoire naturelle où il fondait et assurait durant 10 ans la direction du département « Écologie et Gestion de la Biodiversité ».

Il jouera un rôle considérable dans l’émergence d’une écologie scientifique française qui se situe maintenant au meilleur niveau, œuvrant notamment au lancement de la revue ‘Ecology letters’, l’un des fleurons, toutes disciplines confondues, de la littérature scientifique.

Parallèlement, puis de plus en plus en synergie avec ses activités scientifiques, ses interrogations humanistes ont porté sur le développement durable, la préservation de la biodiversité, les relations science-société. Avec des études menées dans les réserves de biosphère du Mexique dans les années 70, puis en s’investissant dans le programme Diversitas aux côtés de Francesco Di Castri dans les années 90. Très impliqué dans la recherche et les politiques de protection de la nature, il était depuis 2002 président du comité français du programme de l’Unesco sur l’Homme et la biosphère (MAB). Grâce à la dynamique et à l’importance des travaux du comité sous son impulsion, la France a pu retrouver une place au sein du Conseil international de coordination du programme MAB.

Il était également vice-président du Conseil Scientifique du Patrimoine Naturel et de la Biodiversité depuis 2005 auprès du ministère de l’Écologie, du Développement durable et de l’Énergie. Il a pris une part très active dans la rédaction des trois tomes « Des exemples pour la biodiversité » publiés par le CSPNB entre 2007 et 2012. Il présidait le Conseil Scientifique de Parcs Nationaux de France depuis 2007 ainsi que le Conseil d’orientation de l’Agence technique des espaces naturels (ATEN) depuis 2002.

Il a très largement contribué à l’émergence de la biodiversité dans le champ scientifique, de ses développements à partir d’une écologie qui se situe à l’interface entre les sciences de la Nature et les sciences de l’Homme et de la Société.

Pour l’ensemble de sa carrière scientifique, il avait reçu récemment le grand prix de la Société Française d’Ecologie. Il était membre de l’Academia Europaea depuis 1996. Mais par-delà sa carrière scientifique, Robert travaillait aussi à développer une conscience écologique auprès du grand public. Ce qui l’a amené à publier de nombreux ouvrages à destination du plus grand nombre, comme « Un éléphant dans un jeu de quilles » (2006), ou encore plus récemment « La vie, quelle entreprise ! » (2011) avec Jacques Weber, son complice de toujours, anthropologue et économiste. Il écrivait en 2012 « … pour peu que l’on accepte de penser autrement, c’est-à-dire avec une vision écologique du monde, la perspective d’une réconciliation des humains avec la nature pourrait cesser d’être une utopie. Ne voit-on pas se dessiner, sur la base d’une éthique de la biosphère, cet esprit de solidarité écologique dont l’humanité et la Terre ont tant besoin ? » dans sa préface de la ré-édition de « Avant que nature meure – Pour que nature vive ! ».

Robert fut pour nous l’un des plus grands penseurs de ces interactions « homme-nature » dans toute leur finesse et nuances variées. Il était exceptionnel pour raconter à ses étudiants, aux scientifiques, au public, aux milieux politiques, l’indispensabilité de travailler en totale transversalité, très interdisciplinaire, de tout prendre en compte pour aborder ce « tissu vivant aux mailles si complexes et que l’on était en train de détricoter ». Il a été l’un des « grands » au CNRS, à l’UPMC et au Muséum. Sa disparition nous laisse orphelins et malheureux. Elle donne aussi à chacun d’entre nous la responsabilité de poursuivre ses pensées et actions, de nous battre inlassablement, sur de solides bases scientifiques, non pas pour « sauver la planète » mais pour faire en sorte que l’humain ne s’y trouve pas rapidement en trop grand « mal-être » !

Gilles Boeuf et Denis Couvet, 15 décembre 2013

Lire également le communiqué de presse émanant du Muséum national d'histoire naturelle

07:55 Publié dans Actualité des Sciences, Environnement-Écologie | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

Cœur artificiel : une première

Cœur artificiel : une première

par Nicolas Rodrigues

(Notre Temps 24 décembre 2013)

(Dernière mise à jour du 17 mars 2014)

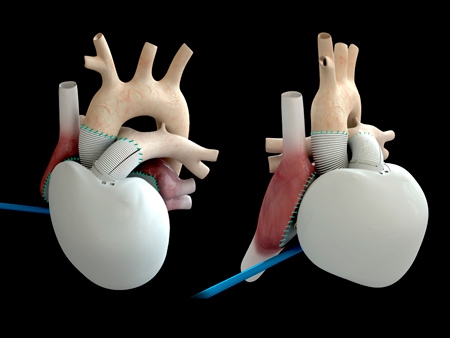

La première implantation d’un cœur artificiel a été réalisée avec succès. Mais quels seront les critères pour bénéficier de cette nouvelle prouesse médicale ?

Une première mondiale

L'opération aura duré une dizaine d'heures. Le 18 décembre 2013, à l'hôpital européen Georges Pompidou à Paris, l'équipe du Pr Christian Latrémouille a implanté un cœur artificiel à un patient de 75 ans atteint d'insuffisance cardiaque terminale. Et aux dernières nouvelles, le patient se porte "bien".

Depuis une dizaine d'années, on implante des cœurs artificiels. Mais cette fois, il s'agit d'un cœur définitif, qui n'est plus seulement destiné à faire patienter le malade avant une greffe.

Cette prothèse mime le fonctionnement du cœur humain : composé de deux ventricules, elle accélère les battements en cas d'effort et ralentit ensuite. De plus, elle est recouverte à l'intérieur d'une membrane biologique pour éviter la formation de caillots de sang. Du coup, Le patient n'a plus besoin de prendre de traitement anti-coagulant lourd.

Le but est d'obtenir une vie normale. Avec tout de même quelques contraintes, comme celles liées à l'alimentation électrique indispensable pour faire fonctionner une telle machine", a commenté le Pr Fabiani, chef du service de chirurgie cardiovasculaire à l'hôpital Pompidou. Les médecins espèrent apporter au malade au minimum cinq ans d’espérance de vie.

La volonté d'un chirurgien français

Cette prouesse médicale est le fruit de la ténacité d'un chirurgien et cardiologue français : le Pr Alain Carpentier, 80 ans, qui tenait absolument à réaliser cette première mondiale en France.

Il y a près de 10 ans, il s'est allié avec EADS, leader de l'aéronautique, pour créer la société Carmat (Carpentier-Matra Défense). Il bénéficie alors d'un soutien financier et technologique. Au total, plus de 100 ingénieurs et médecins ont été impliquées dans ce projet.

Aujourd'hui, Carmat est une start-up cotée en bourse, financée à la fois par des investisseurs privés et publics. Sa technologie représente un espoir pour les patients atteints d'une insuffisance cardiaque terminale: sur 100 000 patients en attente d'une greffe en Europe et aux États-Unis, seuls 4000 bénéficient d'une transplantation chaque année, faute de greffons disponibles.

La mise sur le marché de ce cœur artificiel n'est pas pour demain

Les équipes doivent finaliser l'étude en cours, sous la surveillance de deux comités d'experts indépendants. Si tout va bien, une seconde implantation devrait intervenir dans les prochaines semaines. Au total, quatre opérations sont prévues au cours de cet essai, avant d'engager une 2ème phase sur une vingtaine de patients. "Un an de recul sera nécessaire pour juger le cœur Carmat", prévient le Pr Jean-Noël Fabiani. La société espère démarrer la commercialisation de son cœur en 2015.

Des critères de sélection pour les futurs bénéficiaires

Mais pour en bénéficier, les futurs patients devront répondre à certains critères physiques : ce cœur artificiel nouvelle génération pèse 900 g, bien plus lourd qu'un cœur humain (300 g). De fait, il ne pourra être implanté que chez des personnes assez corpulentes. La société Carmat estime ainsi qu'il est compatible avec 70% des thorax d'hommes et 25 % de ceux de femmes.

Des critères médicaux constituent aussi des contre-indications plus ou moins rédhibitoires : hypertension pulmonaire irréversible, infection active, cancer, voire diabète, insuffisance rénale, obésité morbide, etc.

Enfin, son prix risque de restreindre encore l'accès à ce cœur artificiel. Un bijou technologique qui coûte environ 160 000€. Un coût prohibitif comparé à une greffe cardiaque dont le tarif s'élève en moyenne à 40 000€, auquel s'ajoutent les frais liés à la prise – à vie – de médicaments anti-rejets. Des frais supplémentaires qui ne sont pas nécessaires avec ce cœur artificiel... pour autant, pas certain que la Sécurité sociale puisse le rembourser.

L’alliance de la chirurgie et de l’aéronautique

Si l’idée de Carmat est l’œuvre du célèbre chirurgien Alain Carpentier, cette prothèse n’aurait pu voir le jour sans les finances et l’expertise du groupe aéronautique Matra. Dans les années 80, Alain Carpentier avait en effet convaincu Jean-Luc Lagardère d’investir dans son projet. Mais les deux hommes ne s’attendaient pas à mettre autant de temps pour le faire aboutir. Entre-temps, Lagardère père est mort et Matra a été refondu dans EADS. Mais le groupe européen n’a pas abandonné le dossier.

Ce sont ses ingénieurs qui ont réussi à miniaturiser l’organe artificiel imaginé par Carpentier et qui ont mis au point les capteurs et le microprocesseur qui équipent la prothèse. D’autres implantations en Belgique, Pologne, Slovénie et Arabie Saoudite devraient suivre avant la mise sur le marché de Carmat. Reste également à alléger encore le poids de la prothèse – 900 grammes tout de même – et simplifier son dispositif d’alimentation très contraignant. Et il y a le coût prohibitif de cette petite merveille : 160 000 euros au moins. On doute que la sécurité sociale envisage de le rembourser…

Cette première mondiale ouvre un nouveau chapitre de l’histoire de la médecine. On peut espérer que d’autres organes artificiels verront le jour sur son modèle comme des reins, des foies ou des pancréas. L'homme augmenté est déjà une réalité.

Découvrez l'animation sur : http://www.carmatsa.com/

Mise à jour du 2 mars 2014 : Décès de Claude Dany, premier malade ayant reçu le cœur artificiel.

Pourquoi le cœur artificiel de Claude Dany, implanté le 18 décembre 2013, s'est-il arrêté de battre le 2 mars dernier ? L'un des chirurgiens ayant participé à cette première mondiale, le Pr Daniel Duveau, révélait dimanche au Figaro que « pendant deux heures, à chaque arrêt du dispositif, la machine faisait tout ce qu'elle pouvait pour faire repartir la pompe ».

Pour en savoir plus, lire l'article du Figaro.fr Santé.

07:50 Publié dans Médecine | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

26/12/2013

Cancer : Bactéries intestinales en renfort de la chimiothérapie

Quand les bactéries intestinales viennent en renfort de la chimiothérapie

(Article mis à jour le 5 septembre 2014)

Appelé autrefois "flore microbienne", le microbiote est l'ensemble des microbes (bactéries et champignons essentiellement) qui peuplent notre corps. Ces micro-organismes vivent avec nous, logés à la surface de la peau, dans les cavités buccale et vaginale, et surtout dans notre intestin : celui-ci contient 100 000 milliards de bactéries - soit 10 fois le nombre de nos propres cellules - et leur masse avoisine les deux kilogrammes chez l'adulte !

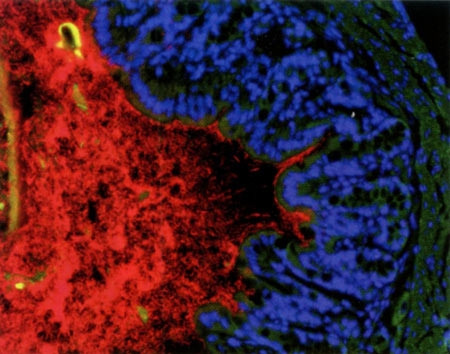

Les bactéries du microbiote apparaissent en rouge

contre la paroi du colon (bleu et vert) © Institut Pasteur

Ce microbiote intestinal est aujourd'hui considéré comme un véritable organe, avec une activité métabolique égale à celle du foie car les espèces bactériennes qui le composent exercent des fonctions cruciales pour notre santé comme l’élimination des substances étrangères à l’organisme (et potentiellement toxiques) ou le maintien à distance de pathogènes qui nous contaminent. Elles assurent également la dégradation des aliments ingérés pour une meilleure absorption intestinale et un métabolisme optimal. Ces milliards de bactéries colonisent l’intestin dès la naissance et jouent un rôle-clef dans la maturation des défenses immunitaires.

Les espèces bactériennes qui composent le microbiote intestinal diffèrent toutefois d'un individu à l'autre et la présence ou l'absence de telle ou telle bactérie semble influencer la survenue de certaines maladies ou au contraire nous protéger. Il nous permet de digérer les sucres complexes et les fibres, intervient dans la biosynthèse des vitamines ou encore dans la détoxification de certaines substances de l'alimentation, et il forme une barrière protectrice contre les pathogènes. Il comprend environ 1000 espèces de bactéries et sa composition varie d'un individu à l'autre. Chacun d'entre nous a donc son propre microbiote intestinal, constitué dans les premières années de la vie à partir des bactéries de notre environnement : seul un tiers des bactéries intestinales est commun à tous.

Ce microbiote intestinal joue un rôle crucial dans le développement du système immunitaire et, sans doute, dans une large gamme de maladies : l'obésité, la résistance à l'insuline et diverses maladies inflammatoires de l'intestin (maladie de Crohn, rectocolite hémorragique...) peuvent résulter d'un déséquilibre du microbiote intestinal. Plus étonnant : il pourrait intervenir dans certaines pathologies de l'humeur comme la dépression. De plus en plus d'études montrent en effet que nos bactéries intestinales envoient des signaux au cerveau et semblent ainsi capables d'influencer le comportement.

Une recherche menée conjointement par des chercheurs de Gustave Roussy, de l'Inserm, de l’Institut Pasteur et de l'Inra a permis une découverte assez étonnante sur la façon dont les traitements de chimiothérapie anticancéreuse agissent plus efficacement grâce à l'aide du microbiote intestinal. Les chercheurs viennent en effet de démontrer que l’efficacité d'une des molécules les plus utilisées en chimiothérapie, repose en partie sur sa capacité à entraîner le passage de certaines bactéries de la flore intestinale vers la circulation sanguine et les ganglions. Une fois dans les ganglions lymphatiques, ces bactéries stimulent de nouvelles défenses immunitaires qui iront aider l'organisme à combattre encore mieux la tumeur cancéreuse.

Arbre phylogénétique bactérien sur fond de muqueuse du côlon d'une souris. La taille des cercles renseigne sur l'importance des populations bactériennes du microbiote. Les points rouges correspondent aux bactéries renforçant l'action d'une immunothérapie anticancéreuse, les verts à celles inhibant la réponse à une chimiothérapie.

Dans le domaine du cancer, l’équipe française* dirigée par le Pr Laurence Zitvogel, à l’Institut Gustave Roussy et directrice de l'Unité Inserm 1015 "Immunologie des tumeurs et immunothérapie", en collaboration étroite avec l’Institut Pasteur (Dr Ivo Gomperts Boneca, Unité "Biologie et génétique de la paroi bactérienne") et des chercheurs de l’INRA (Dr Patricia Lepage et Dr Joël Doré, Unité Micalis "Microbiologie de l'Alimentation au service de la Santé"), vient d'apporter la preuve que la flore intestinale stimule les réponses immunitaires d'un individu pour combattre un cancer lors d'une chimiothérapie.

*Équipe française dirigée par le Pr Laurence Zitvogel, à l'Institut Gustave-Roussy, directrice de l'Unité Inserm 1015 "Immunologie des tumeurs et immunothérapie", en collaboration étroite avec l'Institut Pasteur (Dr Ivo Gomperts Boneca, Unité "Biologie et génétique de la paroi bactérienne") et des chercheurs de l'INRA (Dr Patricia Lepage et Dr Joël Doré), Unité "Microbiologie de l'Alimentation au Service de la Santé Humaine".

Le cyclophosphamide est l’un des médicaments les plus utilisés en chimiothérapie. Comme tout traitement, il entraîne cependant des effets secondaires (inflammation des muqueuses etc.) et perturbe l'équilibre normal du microbiote intestinal. Chez la souris, l'équipe a démontré que le cyclophosphamide modifie la composition du microbiote dans l'intestin grêle et induit la translocation de certaines espèces de bactéries Gram-positives dans les organes lymphoïdes secondaires. Là, ces bactéries stimulent la production d'un sous-ensemble spécifique de "pathogène" T helper(17)" pTH17 cellules mémoire et des réponses immunitaires Th1. La synergie entre le microbiote et le cyclophosphamide débute lorsque le médicament facilite le passage à travers la barrière intestinale des bactéries Gram+ qui vont se retrouver dans la circulation sanguine et les ganglions lymphatiques. Ces bactéries sont considérées comme néfastes et l'organisme déclenche une réponse immunitaire. Une fois dans les ganglions lymphatiques, elles stimulent la production de globules blancs pTH17 qui vont agir comme de nouvelles défenses immunitaires et aider l'organisme à lutter contre la tumeur cancéreuse. "Cette réaction en chaîne, effet secondaire du traitement, va s'avérer en réalité très utile" explique Laurence Zitvogel. "De façon surprenante, la réponse immunitaire dirigée contre ces bactéries va aider le patient à lutter encore mieux contre sa tumeur en stimulant de nouvelles défenses immunitaires."

En détails, l'immunisation anti-bactérienne aboutit au recrutement de lymphocytes effecteurs différents de ceux mobilisés par la chimiothérapie. Leur rôle consiste à aider les lymphocytes anti-tumoraux à endiguer la croissance de tumeurs.

A contrario, des souris dépourvues de tout germe intestinal ou préalablement traitées par des antibiotiques dirigés contre les bactéries Gram+ se révèlent incapables de produire les précieuses cellules pTH17 antitumorales. De plus, leur tumeur est devenue résistante au cyclophosphamide. La situation est toutefois réversible : lorsque les sourisreçoivent une perfusion intraveineuse de pTH17, le médicament retrouve son efficacité antitumorale.

Les chercheurs suggèrent également que certains antibiotiques utilisés au cours d’une chimiothérapie pourraient détruire ces bactéries Gram+ et annuler ainsi leur effet bénéfique. "Maintenant que ces bactéries bénéfiques potentialisant la réponse immunitaire anti-tumorale ont été identifiées, on devrait réussir rapidement à en fournir plus à l'organisme, notamment via des pro- ou pré-biotiques et/ou une alimentation spécifique" conclut la chercheuse.

Ces travaux ont bénéficié du soutien de la Ligue nationale contre le cancer, de l'Institut national du cancer (INCa) (SIRIC SOCRATES) et du LABEX Onco-Immunologie.

Remarque :

Le cyclophosphamide n'est pas le seul traitement à profiter d'un microbiote intestinal performant. Le même numéro de Science fait ainsi part du travail d'une équipe américaine qui aboutit à des conclusions très proches : certains antibiotiques diminueraient l'action de la chimiothérapie.

Parallèlement au travail des chercheurs français, Elizabeth Pennisi, Noriho Lida et al, de l'Institut national du cancer (Frederick, États-Unis), montrent que le microbiote intestinal renforce les effets d'autres traitements anticancéreux, à savoir une immunothérapie ou une chimiothérapie par oxaliplatine (un autre médicament anticancéreux). Ici aussi, comme dans l'étude française, l'efficacité du traitement antitumoral a chuté drastiquement chez des souris débarrassées de leur flore bactérienne intestinale.

Même si ces deux études ont été menées sur la souris, il est vraisemblable que leurs résultats puissent être un jour applicables à l'être humain. Ils suggèrent en tout cas que certains antibiotiques pourraient diminuer l'efficacité d'une chimiothérapie antitumorale mais également qu'une supplémentation en pro- ou pré-biotiques, voire une alimentation spécifique, pourrait renforcer l'action du traitement.

Sources :

Laurence Zitvogel et al (2013). - The Intestinal Microbiota Modulates the Anticancer Immune Effects of Cyclophosphamide, Science22 November 2013, vol 342 n° 6161 pp. 971-976.

Elizabeth Pennisi et al (2013). - Cancer Therapies Use a Little Help From Microbial Friends, Science 22 November 2013 Vol. 342 n° 6161 p. 921.

Marc Gozlan (2013). - La flore intestinale en renfort de la chimiothérapie, Sciences et Avenir, janvier 2014 n° 803, p. 70.

Qu'est-ce que le microbiote ? Lettre de l'Institut Pasteur, septembre 2014 n° 86 p. 9.

11:55 Publié dans Actualité des Sciences, Biologie, Médecine | Tags : cancer, chimiothérapie, microbiote intestinal, flore intestinale | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

24/12/2013

L'exploration du centre de la terre

L'exploration du centre de la terre

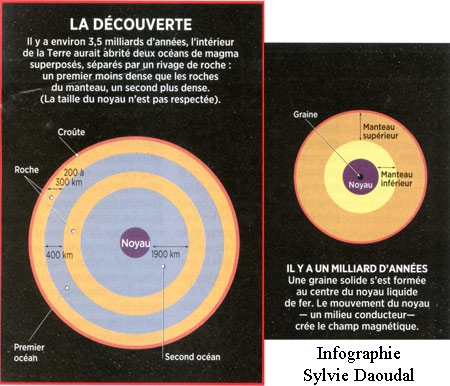

Tout le monde n'est pas Jules Verne : aujourd'hui comme hier, il est impossible de connaître directement l'intérieur de la planète. De sorte que nous avons moins d'information sur ce qui se trame sous nos pieds que sur les soubresauts des astres aux confins du cosmos. Car notre seul messager direct est la lumière. Or, aucun photon ne nous parvient de ces profondeurs alors que la lueur des galaxies lointaines, captée par de nombreux instruments d'observation, renseigne sur de grandes portions de l'Univers.

Creuser la Terre : mission impossible

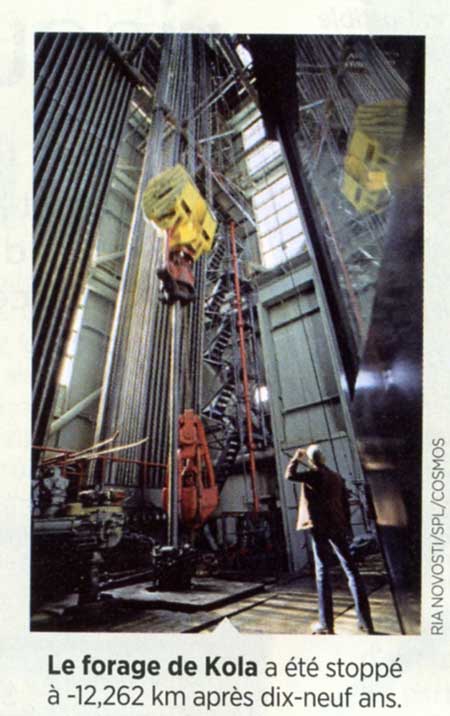

On a bien pensé à effectuer des forages profonds comme celui qu'a entrepris en 1970 une équipe de scientifiques russes qui s'est lancée dans le premier et seul forage très profond de la croûte terrestre qui n'a d'ailleurs jamais pu aboutir.

Depuis la presqu'île de Kola, près de la ville de Zapoliarny (au Nord-Ouest de Mourmansk), l'objectif était d'atteindre au moins le « moho ». Cette frontière virtuelle, du nom du sismologue croate Andrija Mohorovicic, est une « discontinuité » située à la base de la croûte, entre 5 et 10 km sous les océans et entre 30 et 60 km sous les continents. La vitesse des ondes qui s'y propagent augmente brusquement, comme si les roches y changeaient de soudainement. Le moho sous la presqu'île de Kola, dotée d'une croûte océanique, était estimé à 15 km de profondeur. Mais après dix-neuf ans de forage, les travaux ont été stoppés en raison de l'effondrement de l'Union soviétique, à -12,262 km précisément. Le forage était devenu trop difficile : vers 7 à 8 km de profondeur, une série de failles avec circulation de fluide a rendu la poursuite des travaux onéreux. Par ailleurs, la température au fond du trou frôlait les 180°C au lieu de la centaine de degrés attendue. Malgré tout, des roches de plus de 2,7 milliards d'années ont été remontées. Mais aucun échantillon du cœur de la Terre...

Exploration des profondeurs par des méthodes indirectes

Pour accéder aux tréfonds de la planète, il faut donc employer des méthodes indirectes. Tout se passe comme si pour en deviner sa forme et sa constitution, nous frappons sa surface afin de la faire vibrer tout entier. Et c'est en écoutant attentivement sa manière de vibrer, grâce aux sismomètres qui enregistrent les mouvements du sol, qu'on peut en déduire sa forme et sa structure interne – une sphère creuse n'émettant pas le même son qu'une boule pleine. Ce sont les séismes de grande magnitude qui jouent le rôle de ces frappes : celui de Tohoku (Japon), survenu en mars 2011 – à l'origine de la catastrophe de Fukushima — a ainsi fait vibrer le sol... de la région parisienne distant de 9500 km.

Les sismographes ont enregistré un déplacement de quelque trois millimètres, soit un mouvement vertical et horizontal de 6 mm[1]. Or, avant de parvenir jusqu'à la France, les ondes sismiques parties du Japon se sont propagées à travers le noyau et le manteau de la Terre. Leur analyse, comme celle des ondes de chaque séisme, permet donc de reconstituer petit à petit le cœur de la planète : en effet, la vitesse des ondes sismiques varie selon la densité des roches qu'elles traversent. C'est ainsi que l'existence d'une croûte, d'un manteau supérieur, d'un manteau inférieur – tous les trois constitués de roches de densité différente – a été identifiée au cours du XXe siècle. « De même, certaines ondes sismiques, à l'origine de mouvements de cisaillement par exemple, ne peuvent traverser les liquides », rappelle Stéphane Labrosse, du Laboratoire de géologie de l'École normale supérieure de Lyon. L'absence partielle de ces ondes dans les enregistrements a permis au sismologue allemand Beno Gutenberg de conclure en 1912 que le noyau de la Terre était liquide. Puis la mathématicienne Danoise Inge Lehmann a analysé minutieusement en 1936 de nombreux sismogrammes pour déduire l'existence au sein de ce noyau liquide d'une graine solide[2].

Autres techniques : recréer les conditions dans le manteau

Liquide, solide, plus ou moins dense... Les ondes sismiques ne livrent aucune information sur les minéraux qui constituent le manteau. Bien sûr, les volcans se chargent de faire remonter vers la surface des roches du manteau. Mais la lave qui sort des cheminées volcaniques n'est plus dans le même état que les roches solides du manteau. D'où l'idée de reconstituer en laboratoire les conditions qui règnent dans les profondeurs du globe et d'y soumettre des échantillons de lave, par une technique utilisée depuis le milieu des années 1970 par les physiciens.

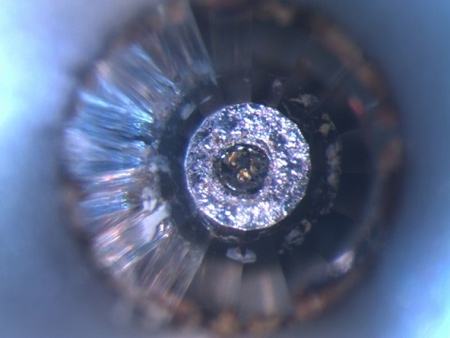

Pour ce faire, leur instrument fétiche s'appelle la « presse à enclumes de diamant ». Son principe : reproduire les pressions qui règnent dans le manteau en enserrant l'échantillon entre deux enclumes en diamant. Seule la dureté de cette pierre précieuse permet en effet de résister à des pressions qui vont de 30 gigapascals (GPa) et que l'on retrouve dans le manteau à 700 km de profondeur — soit 300 000 fois la pression atmosphérique — à 135 GPa à 2900 km, à la frontière du noyau, soit un million de fois la pression atmosphérique. Parallèlement, un faisceau laser vient chauffer 1 échantillon jusqu'à 2000°C. Celui-ci ainsi trituré, comprimé et grillé ressort comme le digne représentant du manteau de la Terre.

Reste à l'analyser aux rayons X pour visualiser l'emplacement des atomes dans la roche. C'est ainsi que les géophysiciens ont compris la différence entre le manteau supérieur et le manteau inférieur. Les mêmes composants chimiques cristallisent différemment en minéraux de plus en plus denses.

Un scénario audacieux révélé par une expérience inédite

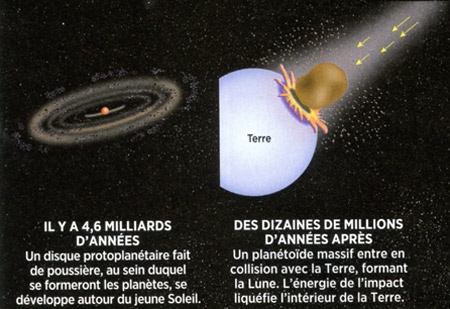

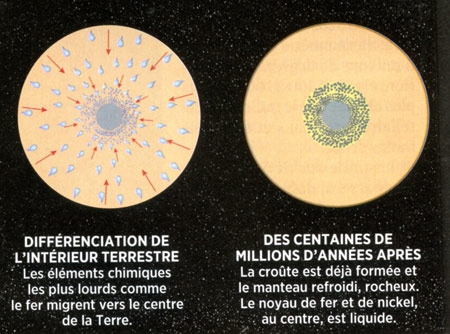

La première expérience d'analyse de magma à très haute pression, par rayons X conforte l'hypothèse d'une Terre primitive à deux océans de magma superposés.

© Christèle Sanloup (Istep CNRS/UPC)

Une équipe européenne (Allemagne, France, Pays-Bas, Royaume-Uni) dirigée par Chrystèle Sanloup de l’Institut des Sciences de la Terre Paris (iSTeP, UPMC/CNRS) a révélé des changements de structure au sein de basaltes fondus à des pressions équivalentes à 1400 kilomètres de profondeur. Cette expérience confirme ce qui avait été suggéré en 2007 : Dans un passé lointain, il y a plus de 3,5 milliards d'années, notre planète aurait renfermé en son sein deux océans de magma séparés par une couche rocheuse. La surface du premier se situe sous 200 à 300 kilomètres de roches depuis la croûte terrestre à une profondeur avoisinant les 400 km, soit 50 fois plus que les plus profondes fosses marines. Sous le plancher de ce premier océan magmatique à 600 ou 700 km de profondeur, se situerait une couche rocheuse cristalline dense sur 300 ou 400 km s'étendant jusqu'à -1000 km. Là, on retrouverait du magma liquide jusqu'à -2900 km de profondeur. En proposant ce scénario à deux étages d'océans, jamais les profondeurs terrestres n'avaient été ainsi pensées[3].

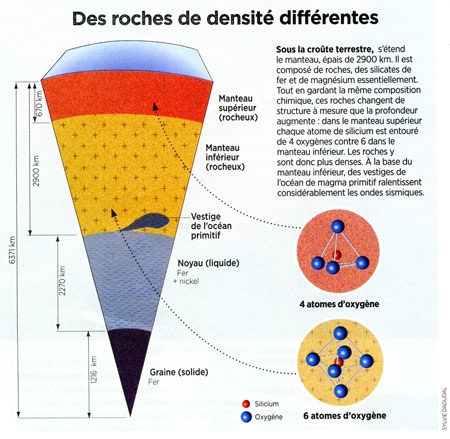

Mais l'équipe est allée plus loin. Au lieu d'utiliser un échantillon de lave refroidi et solide, comme c'était toujours le cas jusqu'alors, elle a eu l'idée de tester du magma. « D'une certaine manière, le magma est plus proche de l'état de la roche telle qu'elle était dans le manteau avant de remonter à la surface », explique Chrystèle Sanloup. Une vraie prouesse technique ! Maintenir de manière stable un liquide entre les mâchoires de la presse n'est pas aisé. Sans compter que les atomes d'un liquide sont désorganisés par rapport à ceux d'un solide. Les chercheurs ont donc dû faire appel à l'une des sources de rayons X les plus puissantes au monde, Petra III, située dans l'installation DESY, près de Hambourg (Allemagne). « Notre surprise a été de constater qu'au fur et à mesure que l'on soumettait le magma à des pressions élevées, sa densité augmentait, mais pas de la même manière que celle de la roche du manteau, explique Crystèle Sanloup. À faible profondeur, le magma flotte sur la roche, mais autour des pressions qui correspondent à 660 km de profondeur, le magma devient plus dense que les cristaux, donc les roches flotteraient sur cet océan de magma... » Ce qui a permis à l'équipe d'imaginer cet épisode surprenant du passé de la Terre, il y a plus de trois milliards d'années, lorsque son intérieur était en grande partie fondu : quand le magma liquide dominait, il a donc pu comporter deux océans superposés.

Échantillon de basalte après manipulation mais toujours dans une cellule à enclumes-diamant (à 35 GPa, on voit trois billes de magma, correspondant à trois spots de chauffage laser, chacun faisant environ 20 microns de diamètre). Sanloup et al. Nature 2013.

Cette étude montre que le nombre de coordination de silicium - son nombre d'atomes voisins -dans les magmas passe de 4 à 6 quand la pression augmente de 10 GPa et 35 GPa. Leur densité passe d'environ 2,7 grammes par centimètre cube (g/cm³) à basse pression, à près de 5 g/cm³ à 60 GPa. Ainsi jusqu’à 25 GPa, soit 660 km , les magmas deviennent progressivement plus denses que les cristaux, qui vont donc flotter et non sédimenter. Une fois le nombre de 6 atomes voisins atteint dans les magmas, soit vers 35 GPa, cette densification devient beaucoup moins notable. C'est ainsi que ce différencient manteau supérieur et inférieur de part et d'autre de la limite de 600 km.

Le changement de structure des magmas avec la profondeur affecte également leurs propriétés chimiques. En effet, les auteurs remarquent que ce changement de structure coïncide avec un changement dans la façon dont des éléments sidérophiles (“qui aiment le fer”), tels le nickel, se répartissent entre magma et fer liquide. Par définition, les éléments sidérophiles se concentrent dans le fer liquide, mais cette concentration est de plus en plus faible à mesure que la pression augmente. Cette forte dépendance en pression en fait de bons marqueurs potentiels de la pression/profondeur d’équilibre entre océan magmatique et noyau métallique. Au-delà de 35 GPa par contre, leur répartition entre magma et fer liquide est peu affectée par la pression.

Pour les auteurs, le comportement plus dense du magma basaltique à une certaine profondeur, permet d’envisager un océan magmatique stratifié dans l'intérieur de la Terre primitive, comme l'ont déjà proposé certains modèles sur la base de calculs d’évolution thermique (refroidissement) de la Terre primitive. Très tôt après leur formation par accrétion de fragments solides, les planètes telluriques sont passées par un état fondu. Épisode qualifié “d'océan magmatique”. La cristallisation de minéraux à partir du magma a commencé à se produire entre probablement environ 660 et 1000 km de profondeur, là ou les cristaux sont en quasi-équilibre gravitaire avec le magma, séparant l'océan magmatique initial en deux océans superposés, qui se sont solidifié à leur tour ne laissant subsister que quelques poches de magma résiduel à la base du manteau inférieur. C’est du moins ce que pensent avoir repéré les sismologues en ayant localisé des zones où les sismiques se propagent à de très faibles vitesses.

Depuis quelques années, les spécialistes des tremblements de terre qui analysent les vibrations du globe font face à une énigme connue sous le nom de « ULVZ » (Ultra Low Velocity Zone, zone à très faible vitesse) qui pourrait des lors se trouver éclairée par cette configuration passée de la Terre. « Lorsque l'on analyse la vitesse des ondes sismiques enregistrées par nos réseaux de sismomètres en surface, tout se passe comme si les ondes qui provenaient de deux régions bien précises — 2900 km sous l'Afrique du Sud et sous le Pacifique présentaient des anomalies : elles s'y propagent bien plus lentement qu'ailleurs, jusqu'à 30 % moins vite. » Or les sismologues le savent bien : les régions chaudes du manteau dissipent l'énergie des ondes sismiques, ce qui fait drastiquement baisser leur vitesse. D'où cette hypothèse très séduisante qu'ils envisagent désormais : à la base du manteau, à 2900 km sous nos pieds, persisteraient les vestiges de ces anciens océans de magma au sein d'un manteau totalement rocheux. En somme, des régions de magma liquide d'une centaine de kilomètres de large, ralentissant les ondes sismiques, seraient encore à l'œuvre. Ce qui expliquerait aussi qu'en surface, à l'aplomb de ces ULVZ, se trouvent deux des plus gros chaudrons du monde dont la lave proviendrait de ces vestiges : les îles Hawaii et les îles Samoa.

Sources :

- Structural change in molten basalt at deep mantle conditions, Chrystèle Sanloup, James W. E. Drewitt, Zuzana Konôpkova´, Philip Dalladay-Simpson, Donna M. Morton, Nachiketa Rai, Wim van Westrenen & Wolfgang Morgenroth Nature 7 novembre 2013.

- Au cœur de la Terre primitive, Azar Khalatbari Sciences et Avenir n° 803 – janvier 2014 pp. 36-39).

- Pour en savoir plus :

http://www.insu.cnrs.fr/node/4592?utm_source=DNI&utm_...

21:26 Publié dans Géologie-hydrogéologie-Climatologie, Volcanologie-Sismologie | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

21/12/2013

Food and Chemical Toxicology (FCT) retire l'article de Séralini sur les rats nourris au maïs OGM NK603

Food and Chemical Toxicology (FCT) retire l'article de Séralini sur les rats nourris au maïs OGM NK603

(Dernière mise à jour : 31 juillet 2014)

On se rappelle de la polémique engendrée par la publication des travaux de Gilles-Éric Séralini portant sur portent sur les effets du maïs transgénique NK603, voir l'article dans ce propre blog.

La revue Food and Chemical Toxicology (FCT) a retiré l'article de Gilles-Éric Séralini de l'université de Caen, sur les rats nourris durant toute leur vie au maïs OGM NK603 tolérant à l'herbicide Roundup, publié en septembre 2012. Cette étude suggérait que les rongeurs développaient plus de pathologies et de tumeurs. Après examen des données brutes, la revue souligne qu'elle n'a relevé ni fraude ni manipulation, mais que « les résultats présentes sont peu concluants » et qu' « il y a une raison légitime d'inquiétude concernant à la fois le nombre d'animaux testés dans chaque groupe et la souche particulière [de rats] ».

Gilles-Eric Séralini, dont l'étude ne cesse de faire polémique. conteste cette décision, persuadé que la revue est sous pression depuis l'embauche, début 2013, d'un nouvel éditeur venu de la société Monsanto, spécialisée dans les biotechnologies. Il argue que la souche de rats (les Sprague-Dawley) qu'il a utilisée l'est aussi en routine aux États-Unis. Il rappelle qu'il a mené une étude inédite sur des rats nourris leur vie entière avec ce maïs OGM et qu'il a multiplié les mesures sur les animaux. Il pointe un article publié par Monsanto en 2004 dans FCT et jamais rétracté, concluant à l'innocuité du maïs NK 603 après avoir mesuré ses effets sur dix rats de la même souche seulement pendant trois mois. Et accuse : « seules les études pointant un effet adverse des OGM sont passées au crible d'une évaluation rigoureuse ». Il pourrait saisir maintenant les tribunaux.

Pour en savoir davantage :

Le 14 novembre 2012, dans une lettre ouverte intitulée «Science et conscience» publiée sur le Monde.fr, 140 scientifiques s'étaient insurgés contre les critiques de l'étude et défendaient le professeur Séralini. Une info reprise récemment par la Tribune de Genève.

Affaire Séralini : publier n'est pas prouver

par Elsa Abdoun (Sciences & Vie, n° 1156, février 2014, p. 16).

II y a un an, le biologiste français Gilles-Eric Séralini faisait la une de tous les journaux après avoir publié dans la revue scientifique Food and Chemical Toxicology un article censé démontrer, images chocs de souris déformées par d'énormes tumeurs à l'appui, la cancérogénicité d'un maïs OGM. À l'époque, nous avions émis de sérieuses réserves sur cette étude (voir Sciences & Vie n°1142, p. 68). Un an plus tard, la revue a finalement fait machine arrière : toujours consultable, elle est désormais accompagnée de la mention "retiré", et ne peut plus être citée dans d'autres articles de chercheurs.

Cette décision, qui entérine le fait que cette étude débouchait sur des conclusions erronées, a valeur d'exemple. Elle pointe la dérive par laquelle le processus de publication scientifique est de plus en plus abusivement utilisé, par des chercheurs, associations ou industriels, pour conférer à leurs opinions un caractère indubitable.

De son côté, Gilles-Eric Séralini explique le retrait de son étude par le fait que la revue s'est dotée, début 2013, d'un éditeur associé, anciennement employé par l'entreprise Monsanto. Laquelle entreprise commercialise le maïs OGM qu'il met en cause... En clair, il serait l'objet d'une censure.

De telles situations de conflits d'intérêts nuisent effectivement à la crédibilité de la science, et jettent une suspicion légitime sur ses délibérations ; mais dans le cas de l'étude Séralini, une chose est sûre : ses conclusions erronées correspondent parfaitement aux critères de retrait établis par le Comité pour l'éthique des publications, qui sert de guide pour les revues scientifiques dans leur gestion des articles qu'elles publient.

Il ressort ainsi que cette étude - incorrecte - n'aurait jamais dû paraître. Il faut donc se rendre à l'évidence: la publication dans une revue scientifique n'est pas une garantie absolue de véracité. Une information cruciale, pour qui ne veut pas se voir berné par de tels artifices. Comme ceux employés par Gilles-Eric Séralini.

En effet, le principal argument de ce chercheur face à la remise en question de son étude est d'avoir été publié par une revue à "comité de lecture". En d'autres termes, l'étude, préalablement relue et "validée par des pairs", était au-dessus de tout soupçon. Un argument non valable, qui semble ignorer que l'analyse d'un article est un exercice faillible, sujet aux erreurs humaines. Pour preuve : de nombreuses autres études sont, chaque année, publiées à tort. Plus de la moitié des articles seraient concernés, selon plusieurs chercheurs qui se sont penchés sur la question. Pis, la plupart ne sont même pas retirés une fois l'erreur confirmée, car "cela reviendrait, pour les journaux, à admettre que leur système de relecture est défectueux ", explique Ivan Oransky, auteur du blog Retraction Watch qui recense depuis 2010 tous les retraits de publications scientifiques.

Pour les éditeurs de l'étude Séralini, la question de reconnaître ou non leur erreur ne s'est pas posée : les agences de sécurité alimentaire européenne (Efsa), française (Anses) et même allemande (BfR), le Haut Conseil des biotechnologies, six académies nationales ainsi que de très nombreux spécialistes de toxicologie, cancérologie et statistiques l'ont fait pour eux. Il faut dire que l'étude, ultra-médiatisée, a été lue par un très grand nombre de chercheurs, s'exposant dès lors aux critiques.

Au final, s'il ne nous a rien appris sur les OGM, le professeur Séralini aura au moins démontré cela : les revues sont truffées de conclusions fausses. De quoi inciter à la prudence...

Février 2014 : Séralini insiste et signe : les pesticides seraient mille fois plus toxiques que ce qu'on croyait.

Voir l'article de Metronews

Ajout de juillet 2014 : Gilles-Éric Séralini republie son étude sur les OGM

Gilles-Éric Séralini, professeur de biologie à l'université de Caen republie son étude sur les OGM Le chercheur avait créé la polémique avec un article sur des rats nourris au maïs transgénique. Il le complète avec les données brutes.

Huit mois après le retrait forcé de son article sur le maïs NK603, le professeur Gilles-Éric Séralini, de l'université de Caen, a republié son article dans une autre revue, Environnemental Sciences Europe (Springer). L'étude controversée suggère que des rats nourris pendant deux ans avec du maïs NK603 — tolérant à l'herbicide Roundup développé par Monsanto — connaissent une mortalité et une incidence de tumeurs plus précoces et plus nombreuses que les rats nourris avec un maïs traditionnel. À la suite des critiques, l'équipe du Pr Séralini la republie avec, cette fois, les données brutes, et rappelle que « le protocole choisi était celui d'une étude de toxicologie sur deux ans et non celui d'une étude de cancérogénèse » et que « d'innombrables études toxicologiques utilisent la souche de rats Sprague Dawley, tandis que les études de Monsanto réalisées à trois mois sur ses OGM utilisent les mêmes effectifs et... la même souche ».

Les détracteurs de Gilles-Éric Séralini pointent que le scientifique ne publie toujours pas de photos des « rats contrôle ». Ces animaux nourris sans OGM pourraient en effet avoir développé eux aussi des grosseurs spectaculaires, comme les rats nourris aux OGM et pesticides. La publication des images de rongeurs aux corps déformés avait largement participé au retentissement médiatique de l'article.

Source : Sciences et Avenir n° 810 Août 2014 p. 21.

09:23 Publié dans Environnement-Écologie, Pollution | Tags : ogm, monsanto, séralini, maïs nk603 | Lien permanent | Commentaires (2) | ![]() Facebook | | |

Facebook | | |

12/12/2013

Chalutage en eaux profondes

Chalutage en eaux profondes

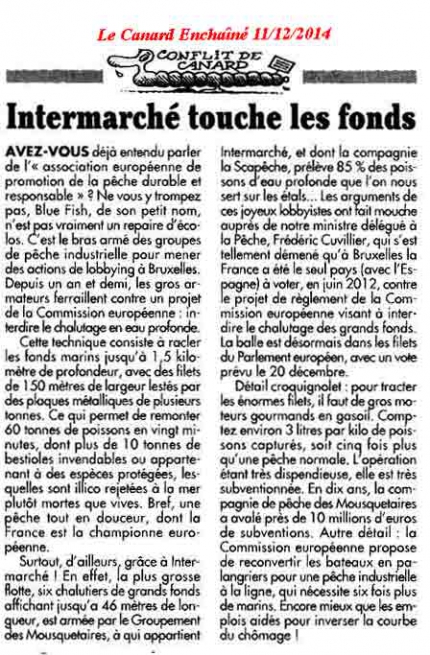

Le 10 décembre, le Parlement européen devait décider s'il interdit le chalutage en eaux profondes, qui provoque des dégâts écologiques majeurs dans les abysses.

Lire l'article du "Canard Enchaîné" à ce propos en pièce jointe (où l'on apprend que les grandes surface et particulièrement la marque INTERMARCHÉ) possèdent une flotte de 6 chalutiers de ce type.

Et aussi cette courte vidéo du "Monde" sur dailymotion.

07:11 Publié dans Environnement-Écologie, Poissons | Tags : pêche en eau profonde | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

10/12/2013

La Soufrière de Guadeloupe sondée par rayons cosmiques

La Soufrière de Guadeloupe sondée par rayons cosmiques

La Soufrière de Guadeloupe sondée par rayons cosmiques

par Nolwenn Lesparre[1], Dominique Gibert[2]

et Jacques Marteau[3]

(Pour la Science n° 434, décembre 2013 pp. 44-51)

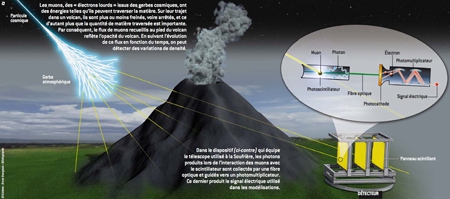

Prévoir les éruptions volcaniques reste un défi pour les scientifiques. Une nouvelle méthode appliquée à la surveillance de la Soufrière de Guadeloupe : la radiographie par les muons cosmiques une solution qui permet de radiographier l'intérieur des volcans ?

(Pour la présentation de la Soufrière voir les articles La Soufrière de Guadeloupe et La Soufrière de Guadeloupe et ses séismes dans ce même blog)

Parmi les différents scénarios d'éruptions envisageables pour la Soufrière, on peut craindre un effondrement du dôme, une éruption phréatique ou une remontée de magma. Risque-t-on une explosion du type de celle de 1980 au Mont Saint-Helens, comme cela s'est déjà produit il y a quelque 3 000 ans ? Pour prévoir ces événements de façon fiable et suffisamment à l'avance pour évacuer les populations concernées, les volcanologues disposent de diverses méthodes pour ausculter le volcan et essayer de prévoir quand surviendra un tel événement et quelle en sera la violence. Une nouvelle méthode a été expérimentée à la Soufrière : la radiographie par les muons cosmiques.

La Soufrière de Guadeloupe

En quoi consiste la méthode ?

Elle n'est pas sans rappeler la radiographie aux rayons x. Ces derniers traversent l'organisme, sont plus ou moins absorbés par les tissus et les os qu'ils rencontrent sur leur passage, et nous donnent des images de l'intérieur du corps humain, liées à cette absorption variable. De même, les rayons cosmiques traversent la matière. Serait-il possible d'observer les entrailles des volcans au moyen de ces rayons cosmiques, plus ou moins absorbés par la matière qu'ils traversent ? L'idée fut proposée au milieu des années 1960 par l'équipe de Luis Alvarez (1911-1988), lauréat du prix Nobel de physique en 1968 : il suggéra d'utiliser les rayons cosmiques pour ausculter la grande pyramide de Khéphren et y rechercher la chambre de la Reine.

Découverts en 1912 par le physicien américain d'origine autrichienne Victor Hess, les rayons cosmiques arrivant sur Terre sont constitués d'une « pluie » de particules produites par les rayons cosmiques primaires qui bombardent l'atmosphère terrestre. Les particules produites dans ces «cascades» sont de natures variées : électrons et photons, entre autres, mais aussi muons. Le muon est une particule élémentaire qui a les mêmes propriétés que l'électron, si ce n'est qu'il est instable (sa durée de vie est égale à 2,2 microsecondes) et que sa masse est environ 200 fois supérieure (206,8 fois précisément). Les muons sont parfois surnommés électrons lourds. Ce sont ces muons qu'utilisa l'équipe d'Alvarez pour « voir » à travers les épaisses parois de la pyramide.

C'est au milieu des années 1990 que l'équipe japonaise de Kanetada Nagamine eut l'idée d'utiliser les muons cosmiques pour ausculter les volcans. Depuis, les détecteurs de particules ont été notablement améliorés, ce qui a conduit plusieurs équipes à s'intéresser à la radiographie des volcans à l'aide des muons. Avoir accès à de telles images permettrait de suivre l'évolution des entrailles des volcans et, par exemple, de détecter une remontée de magma ou l'apparition de poches de vapeur avant toute manifestation visible.

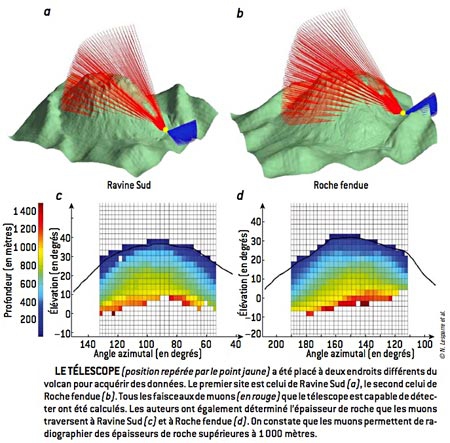

Parmi ces équipes, le groupe Diaphane réunit des géophysiciens et des physiciens des particules de l'Institut de physique du Globe de Paris, de l'Institut de physique nucléaire de Lyon et du laboratoire Géosciences Rennes. Cette équipe mène des expériences sur plusieurs volcans aux Philippines, sur l'Etna et aux Antilles, où elle s'intéresse surtout à la Soufrière, surveillée en permanence par l'équipe de l'Observatoire volcanologique de Guadeloupe.

Rappelons que ce volcan subit des éruptions phréatiques, c'est-à-dire l'expulsion violente de grands volumes d'eau sous forme de panaches de vapeur. L'accès du volcan est difficile car le sommet (1 467 mètres) est entouré d'une forêt tropicale dense jusqu'à 1 100 mètres d'altitude dans un relief abrupt. Les pluies tropicales abondantes sont accompagnées de fortes rafales, toutes conditions qui rendent la surveillance difficile. Dès lors, la tomographie par rayons cosmiques présente l'intérêt théorique de suivre les entrailles du volcan sans avoir à l'escalader. Restait à démontrer la faisabilité de la méthode et sa fiabilité.

Les muons, que nous avons déjà mentionnés, sont produits à une quinzaine de kilomètres d'altitude lors des collisions entre les rayons cosmiques primaires et les atomes de l'atmosphère. Les particules primaires résultent de phénomènes astrophysiques violents, telles les explosions d'étoiles en supernovae, au cours desquelles elles sont accélérées. Les plus énergétiques détectées à ce jour ont une énergie d'environ 3,2 x 1020 électronvolts, c'est-à-dire plus que les plombs d'une carabine à air comprimé !

Lorsqu'elles pénètrent dans l'atmosphère, ces particules heurtent les molécules d'air. Sous le choc, de nouvelles particules sont libérées et se désintègrent à leur tour. Une cascade de désintégrations conduit à une averse de particules, nommée gerbe atmosphérique. Certains observatoires – HESS2, en Namibie, ou l'Observatoire Pierre Auger, en Argentine – sont consacrés à l'étude de ces phénomènes.

Les muons représentent cinq pour cent des milliards de particules qui constituent une gerbe atmosphérique. Leur énergie est comprise entre quelques dizaines et quelques milliers de gigaélectronvolts. Ils se déplacent à une vitesse proche de celle de la lumière dans le vide, ce qui allonge considérablement leur durée de vie apparente grâce à des effets relativistes. Cela leur permet de traverser l'atmosphère et d'atteindre le sol. Aux énergies considérées, les muons interagissent essentiellement par ionisation des atomes de la matière qu'ils traversent.

Les muons que... presque rien n'arrête

La perte d'énergie est approximativement constante et d'environ deux mégaélectronvolts par centimètre d'eau traversée. L'atmosphère ayant une épaisseur équivalant à dix mètres d'eau, les muons perdent deux gigaélectronvolts pour parvenir jusqu'au sol.

Les muons ne s'arrêtent pas en touchant le sol. Ils traversent la matière, où ils perdent de l'énergie plus rapidement que dans l'air. Si leur énergie est suffisamment grande et l'obstacle pas trop dense, ils peuvent le traverser de part en part. Si la densité de l'obstacle est trop élevée, ils sont arrêtés. On retrouve ici le principe de la radiographie aux rayons x, et on peut l'appliquer à la radiographie (ou tomographie) de l'intérieur d'un volcan. On mesure l'atténuation du flux de muons cosmiques produite par le volcan. L'atténuation augmente avec la quantité de matière traversée ou plus précisément l'opacité, c'est-à-dire le produit de la densité moyenne par la longueur du trajet dans le volcan.

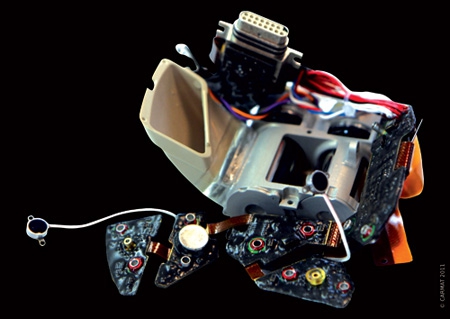

Principe de la radiographie des montagnes par les muons

(Pour zoomer, cliquer sur l'image)

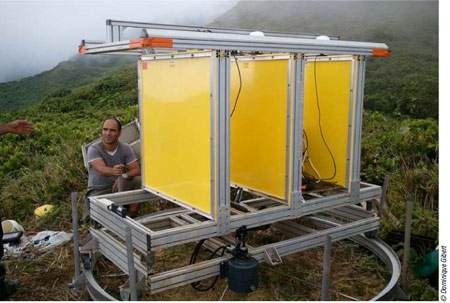

Le principe décrit, comment procède-t-on en pratique ? On dispose d'un détecteur de particules – également nommé télescope, car on observe des rayons cosmiques – placé au pied du volcan et qui enregistre un flux de muons. Le télescope utilisé à la Soufrière est robuste, résistant aux variations de température, insensible aux pluies tropicales et aux ouragans. Il est également léger et maniable, transportable par hélicoptère et déposé sur des pentes escarpées. Deux ou trois personnes peuvent l'installer. Un vérin hydraulique et une base rotative permettent de modifier l'orientation du télescope et de l'ajuster avec précision. Il est alimenté par des panneaux solaires, une éolienne ou une pile à combustion.

Le détecteur de particules ou télescope

Le télescope est équipé de barreaux scintillants arrangés en deux séries perpendiculaires, de façon à former un damier constituant une matrice. Un télescope comporte au minimum trois matrices de 256 pixels de 25 centimètres carrés permettant de détecter les muons provenant de 961 directions différentes. La résolution angulaire est adaptée en ajustant la distance entre les matrices.

Lorsqu'une particule chargée traverse un barreau, la matière est ionisée et émet des photons avant de revenir à son état initial. L'énergie perdue par l'ionisation d'un muon produit entre 15 000 et 20 000 photons ultraviolets. Une fibre optique, collée au cœur du scintillateur, capture une partie de ces photons et les guide vers un photomultiplicateur qui produit une impulsion électrique. Ainsi, les muons produisent des photons que le photomultiplicateur convertit en électrons, signal électrique amplifié et mis en forme par un système électronique adapté de l'expérience OPERA (dédiée à l'étude des particules élémentaires nommées neutrinos). Les horloges utilisées pour repérer le passage de chaque muon ont une précision de quelques dizaines de picosecondes. Un ordinateur central collecte les informations provenant des différentes matrices et, dans le cas de la Soufrière, les transmet à l'observatoire volcanologique situé à une dizaine de kilomètres du volcan. Cela permet de mesurer un flux de muons en temps réel et de détecter d'éventuelles variations dues à des changements de conditions à l'intérieur du massif.

Le flux de muons décroît quand l'opacité augmente, et la mesure de son atténuation reflète les variations de densité à l'intérieur de l'objet sondé. Pour modéliser les variations de densité dans le volcan, nous résolvons ce que l'on nomme un problème inverse, méthode qui nous permet de déduire l'opacité du volcan du flux de muons l'ayant traversé. La tomographie par analyse du flux de muons nous donne des images de densité avec une résolution d'une vingtaine de mètres.

Comment calibrer le détecteur

Toutefois, restent encore plusieurs difficultés à résoudre : comment calibrer le détecteur pour obtenir une image de résolution optimale ? Comment évaluer la durée minimale d'enregistrement des données? Et comment déduire du flux de muons enregistré les variations d'opacité du volcan ? D'abord, il est important d'estimer le flux de muons observables, afin d'ajuster la configuration du détecteur.

Mais le calcul du flux de muons traversant une montagne nécessite de connaître approximativement la répartition des densités dans cet objet. Pour ce faire, on utilise les connaissances accumulées au fil du temps par les géologues. Bien sûr, on ignore les détails de l'anatomie du volcan, mais l'activité de la Soufrière est suivie depuis longtemps, ses failles et sa cheminée ont été explorées par divers moyens, de sorte que l'on a une idée de la répartition des masses en son sein.

Partant de ces données obtenues par d'autres méthodes, on estime le flux en fonction de la position du télescope par rapport à l'objet, de son orientation et de sa configuration. On peut alors évaluer les épaisseurs de roche traversées par les muons pour chacun des angles de vue du télescope. Ces épaisseurs sont ensuite converties en opacité, caractéristique qui détermine le seuil d'énergie minimale nécessaire aux muons pour traverser l'objet sans être absorbés. Le flux de muons détectables correspond alors au flux de muons arrivant à la surface du volcan et dont l'énergie est suffisante pour qu'ils puissent en ressortir.

Les radiographies de la Soufrière

Qu'avons-nous observé ? De nombreux signes témoignent de l'activité actuelle du volcan : des fractures, des fumerolles, le lac d'acide du gouffre Tarissan et des zones altérées par le système hydrothermal. Nous avons installé notre télescope successivement en trois endroits à l'Est, au Sud et à l'Ouest du volcan. Le fait d'avoir plusieurs points de vue permet de valider l'analyse des données.

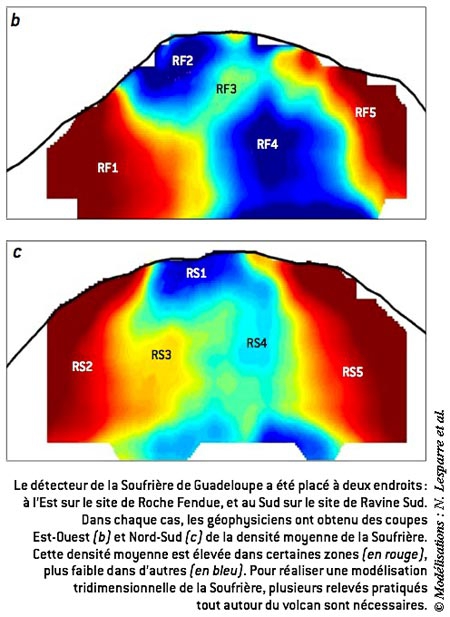

Les radiographies montrent des zones de très faible densité dans la partie supérieure du volcan ; elles sont associées à la zone active du cratère Sud (nommées rf2 et rs4) et indiquent la présence d'un réseau de cavités (voir le schéma ci-dessous). Elles révèlent aussi une région peu dense (rf4) à la base du dôme, pouvant correspondre à la présence de roches altérées par les fluides hydrothermaux. Les régions de densité plus élevées (par exemple rf1 et rf5) révèlent l'existence de roches non altérées, en particulier de l'andésite mise en place lors de la formation du dôme. Des régions de densités intermédiaires (rf3) correspondraient à des barrières rocheuses localisées entre les réservoirs hydrothermaux.

Nos radiographies présentent une bonne résolution spatiale. Elles ont été comparées à des images obtenues à l'aide d'autres méthodes géophysiques : les différentes images révèlent des structures similaires à l'intérieur du volcan. Par exemple, une tomographie électrique avait été effectuée à travers le dôme, apportant des informations sur les structures superficielles. Ce type d'images est sensible à la présence de fluides conducteurs et révèle les passages où les fluides du système hydrothermal circulent. Cependant, la résolution spatiale de la méthode n'atteint pas celle de la tomographie par analyse du flux de muons.

Après la réalisation de ces deux radiographies, le télescope est resté installé pendant plusieurs mois sur le même site. Durant ce suivi, nous avons enregistré une augmentation du flux de muons à travers certaines zones du volcan, où l'écran rocheux est tel que seuls les muons de haute énergie le traversent. Or, quand on fait la moyenne du flux de ces muons sur quelques jours, on constate qu'il est constant. Si l'on observe une augmentation du flux, c'est nécessairement que la densité du milieu a diminué.

En effet, la région concernée correspond à un site où des fumerolles présentent un regain d'activité. Par conséquent, il est possible qu'à la suite d'une réorganisation de la circulation des fluides à l'intérieur de l'édifice, les roches de la région étudiée se soient appauvries en eau. Cette observation, qui doit être confirmée par des mesures indépendantes, montre l'intérêt de la tomographie par muons pour la surveillance des volcans en continu.

Une surveillance en continu

Ainsi, l'installation d'un télescope sur les flancs de la Soufrière de Guadeloupe a permis de montrer qu'un détecteur adapté au milieu tropical fournit des radiographies intéressantes des entrailles du volcan. La méthode permet de distinguer les hétérogénéités à l'intérieur de l'édifice. Les nouvelles données accumulées devraient permettre de concevoir des modèles plus précis de l'évolution du volcan. Un suivi régulier de cette évolution devrait révéler les changements internes d'opacité. Géophysiciens et volcanologues pourront-ils alors prévoir d'éventuelles éruptions ? C'est bien sûr ce que nous espérons.

Cette expérience a été réalisée sur un volcan de type explosif, mais elle est aussi applicable à des volcans de type effusif, tel l'Etna. Quel que soit le type éruptif d'un volcan, il présente des structures internes plus ou moins denses liées à la présence de cavités, d'une colonne éruptive, de roches massives ou de cendres et de ponces... Nous l'avons souligné, le télescope utilisé à la Soufrière offre de nombreux avantages (résistant, manipulable, précis, etc.), et la méthode permet de tomographier à distance des volcans dangereux, par exemple la Soufrière Hills de Montserrat. Toutefois, la tomographie par muons présente un inconvénient : elle n'est pas applicable partout.

Cette technique est bien adaptée au dôme de la Soufrière, qui a un diamètre de l'ordre du kilomètre et dont les pentes sont abruptes. Le flux de muons est suffisant pour obtenir en un mois une série de données exploitables. En revanche, un volcan de type bouclier comme le Piton de la Fournaise, à la Réunion, est moins adapté, car sa base est large de plusieurs kilomètres et ses pentes sont plus douces.

Dès lors, le flux de muons est fortement atténué par l'épaisseur de la roche, et il faudrait recueillir les données durant plusieurs mois, voire quelques années, pour commencer à distinguer les structures internes. Lors de l'expérience que nous avons réalisée sur l'Etna, volcan culminant à 3 300 mètres d'altitude, nous avons dû limiter notre étude à l'un des cratères sommitaux, le cratère Sud-Est, dont les dimensions sont comparables à celles de la Soufrière de Guadeloupe.

La tomographie par muons serait-elle applicable à d'autres objets que les volcans ? Oui, à condition de pouvoir aligner le flux de muons cosmiques, l'objet et le détecteur. D'autres applications sont envisageables, et un télescope a récemment été installé dans le laboratoire souterrain de l'Institut de radioprotection et sûreté nucléaire, IRSN, à Tournemire, pour caractériser les roches présentes au-dessus des galeries.

De la Soufrière au suivi des nappes phréatiques

La méthode pourrait servir à caractériser le milieu recouvrant des sites de stockage géologique ou à évaluer des ressources minières. Les mesures effectuées en continu sur la Soufrière ont également montré la possibilité d'observer des variations de densité. La méthode permettrait aussi d'évaluer les dimensions de nappes phréatiques et de suivre leurs fluctuations, ou encore de surveiller les sites de stockage de dioxyde de carbone. Cette toute jeune méthode devrait trouver de nombreuses applications !

La Soufrière de Guadeloupe est un volcan actif, qui est déjà entré en éruption à diverses reprises. En radiographiant ses entrailles à l'aide de muons, pourrait-on mieux prévoir les risques potentiels ?

Pour en savoir plus :

N. Lesparre et al., Density muon radiography of La Soufrière of Guadeloupe : First results and comparison with other tomography methods, Geophys. J. Int., vol. 190, pp. 1008-1019, 2012.

J. Marteau et al., Muons tomography applied to geosciences and volcanology, Nucl. Instrum. Methods A, vol. 695, pp. 23-28, 2011.

N. Lesparre et al., Geophysical muon imaging : feasibility and limits, Geophys. J. Int., vol. 183, pp. 1348-1361, 2010.

J. Paul et J.-L. Robert-Ésil, Le roman des rayons cosmiques, Ellipses, 2009.

P. De Wever et al., Le volcanisme cause de mort et source de vie, Vuibert, 2003.

Ouvrage de 248 pages aux Éditions universitaires européennes (9 novembre 2011)

ISBN-10: 3841780857 ISBN-13: 978-3841780850

[1] Nolwenn LESPARRE est géophysicienne à l'Institut de radioprotection et de sûreté nucléaire, à Fontenay aux Roses. Elle a été lauréate du Prix Le Monde de la recherche universitaire 2012.

[2] Dominique GIBERT est géophysicien à l'Institut de physique du Globe de Paris et professeur à l'Université de Rennes 1. Il coordonne le projet DIAPHANE.

[3] Jacques MARTEAU est physicien des particules à l'Institut de Physique nucléaire de Lyon. Il a travaillé sur les expériences neutrinos OPÉRA et t2k.

12:07 Publié dans Volcanologie-Sismologie | Tags : arc antillais, volcanisme, éruption volcanique, éruption phréatique, soufrière de guadeloupe, radiographie par muons cosmiques | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

04/12/2013

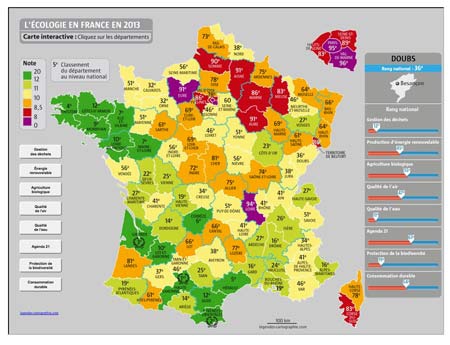

Le palmarès 2013 de l'écologie en France

Le palmarès 2013 de l'écologie en France

Voilà déjà 7 ans que l’hebdomadaire La Vie publie chaque année son palmarès de l’écologie. Objectif : passer au crible les politiques environnementales de chaque département, comparer ces critères identiques aux autres, et établir un classement. Avant de passer à celui-ci, attardons-nous sur la méthode employée et les 8 critères de sélection.

- Il y a d’abord la « consommation durable » qui consiste à rapporter le nombres de magasins durables (bio, équitable, AMAP) au nombre d’habitants de chenue zone étudiée.

- Il y a ensuite la protection de la biodiversité : quelle est la superficie d’espaces protégés dans les départements ? Les oiseaux et les papillons sont-ils en nombre satisfaisant ?

- Vient alors le critère de la place accordée à l’agriculture bio : nombre de cultivateurs, part du bio, etc.

- La gestion des déchets est bien entendu un critère primordial pour établir un tel classement : volume collecté, nombres de sites pollués…

- La Vie prend aussi en compte, pour chaque division du territoire, la part d’habitants concernés par la mise en place d’un Agenda 21.

- La part d’énergies renouvelables (solaire, éolien ou biogaz) dans le mix énergétique des départements est également prise en compte.

- Enfin, qualité de l’air et qualité de l’eau sont les dernières variables qui entrent en considération.

Pour chacun de ces critères, l’hebdomadaire s’appuie sur des rapports provenant des ministères, des départements, des agences nationales ou d’associations spécialisées.

Sur la carte interactive du projet, on constate ainsi que si le Nord-Est semble être la zone du pays qui se conforme le moins au développement durable (et on inclue là toute la région parisienne), le Sud-Ouest (avec la Haute-Garonne, les Pyrénées-Orientales et la Gironde, qui occupent respectivement les 3 premières places) et la Bretagne (dont les 4 départements font partie des 12 mieux classés) apparaissent comme les meilleurs élèves.

Même s’il éclaire sur le chemin qu’il reste encore à parcourir pour devenir un pays exemplaire en matière d’environnement, il convient parfois de mesurer son enthousiasme : le Finistère, 4ème du classement, est pourtant 86ème (sur 96) sur le critère de la qualité de l’eau. Les Pyrénées-Orientales, brillant 2ème, sont pourtant 91èmes lorsqu’il s’agit de protéger la biodiversité.

Cette mesure est également valable pour les mal classés. Le Territoire de Belfort, 86ème au général, est pourtant 2ème quant à la gestion de ses déchets, et 7ème pour la qualité de son eau. La Seine-Saint-Denis, classée 89ème, est pourtant le 4ème meilleur élève du pays pour la mise en place de l’Agenda 21.

Découvrez le palmarès département par département en cliquant sur la carte interactive ci-dessous et en navigant département par département.

En complément à cette étude comparative, on pourra consulter le plan national de prévention des déchets 2014-2020.

10:24 Publié dans Environnement-Écologie, Pollution | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |