28/02/2013

Audition et surdités

L'Oreille,

L'Oreille,

l'Audition

et

les surdités

I. L'audition permet la communication

L'audition est le sens de l'ouïe, c'est-à-dire de la perception des sons.

1. Qu'est-ce que le son ?

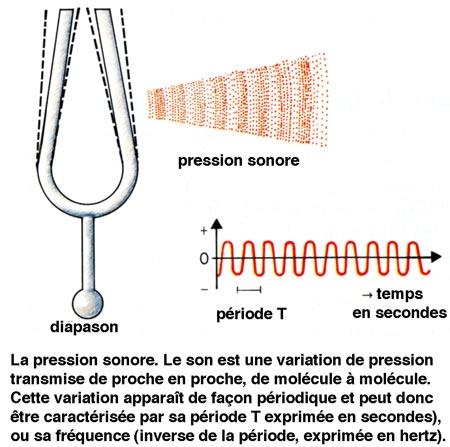

Le son est lié à une variation de pression du milieu. Il correspond à la mise en oscillation d'un milieu. Dans le cas de l'homme, il s'agit généralement de l'air, mais l'émission et la conduction sonores peuvent se faire également en milieu liquide ou solide. L'énergie est ensuite transmise, de molécule à molécule, à une vitesse de 340 m.s-1 (dans l'air). Les ondes sonores correspondent à l'alternance de zones de pression élevée et de zones de pression faible. L'amplitude des variations de pression est qualifiée de pression sonore. Elle peut être mesurée à l'aide d'un microphone, qui traduit la variation de pression en une variation de tension électrique.

Compte tenu de l'importance de la gamme des niveaux sonores, l'échelle utilisée pour quantifier les pressions sonores est logarithmique. Le niveau de pression de référence PO a été placé légèrement en dessous du seuil de stimulation moyen de l'oreille. Pour une fréquence de 1000 Hz ; il est égal à 2.10-5 N.m-2. Ainsi, le niveau de pression sonore S d'un son donné est égal à :

S = 20 log (P/Po)

L'unité de S est appelée le décibel (dB). À 1 000 Hz, un décibel équivaut à un phone.

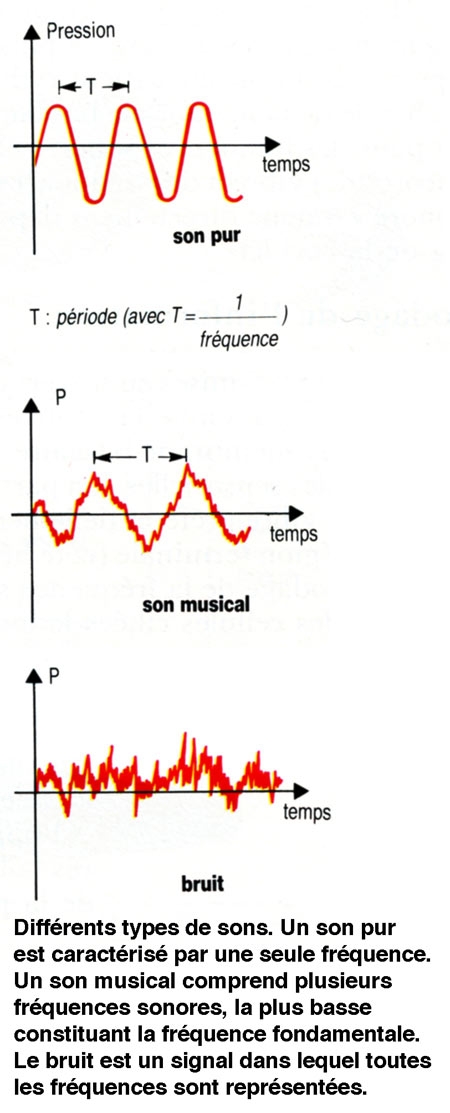

Un second paramètre du son est sa fréquence. Celle-ci est exprimée en cycles par secondes ou herz (Hz). Un son constitué d'une seule fréquence est qualifié de son pur. Cependant, un son est généralement constitué d'un mélange de plusieurs fréquences : une fréquence minimale ou fondamentale et des fréquences multiples de cette fondamentale ou harmoniques. Un son dans lequel toutes les fréquences sont représentées de façon quasi identique est qualifié de bruit blanc.

2. La sensibilité de l'ouïe varie avec la fréquence du son

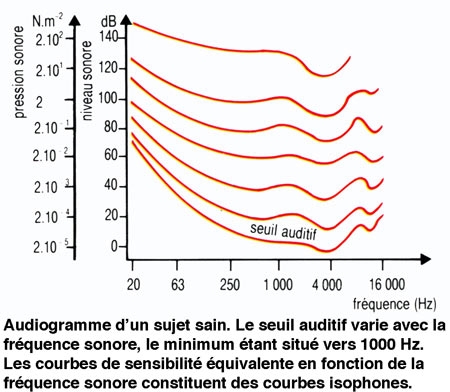

L'homme est sensible à des vibrations sonores comprises entre 20 Hz et 20 000 Hz (ou 20 kHz). Le seuil d'audition varie en fonction de la fréquence d'un son pur stimulant. Il est minimal pour une fréquence de 1 kHz, et de l'ordre de 4 dB ou 4 phones. Au-delà de ce seuil, la sensibilité varie également en fonction de la fréquence du son stimulant. Ce phénomène peut être représenté sous forme de courbes isophones. À partir d'une valeur d'environ 130 phones, une sensation douloureuse remplace la sensation auditive. De tels sons peuvent endommager l'appareil auditif. Les ondes sonores émises au cours du langage parlé correspondent aux zones de meilleure sensibilité auditive.

3. Des sons graves et des sons aigus

La fréquence sonore est généralement décrite sous forme de hauteur d'un son. Un son grave est un son de basse fréquence, et un son aigu un son de haute fréquence. Dans la musique occidentale, la fréquence sonore est organisée en octaves. Un accroissement de la valeur tonale d'une octave s'obtient en doublant la fréquence d'un son.

4. Deux oreilles pour faciliter l'orientation auditive dans l'espace

Une écoute à l'aide des deux oreilles permet à un sujet de situer la source sonore dans l'espace. Le son étant conduit à vitesse finie, il ne parvient en même temps au niveau des deux oreilles que si rémission sonore a lieu dans l'axe de la tête. Dans les autres cas, l'onde sonore atteint les deux oreilles avec un décalage temporel qui permet au sujet de détecter la position de l'émetteur sonore.

II. Anatomie de l'oreille et physiologie de l'audition

1. Les sons sont canalisés avant de frapper l'oreille interne

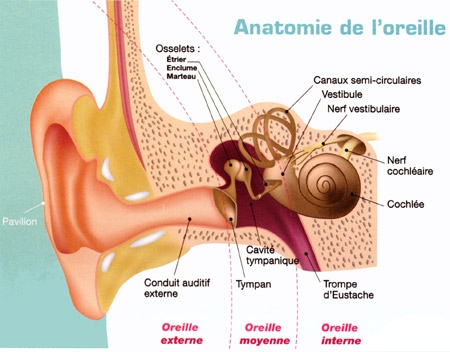

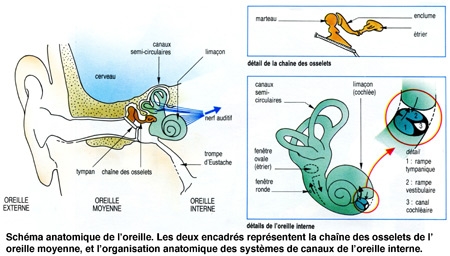

L'oreille représente l'organe de l'audition. En fait, ce que nous avons coutume d'appeler l'oreille n'est que sa partie apparente. L'oreille se compose en réalité de trois parties : externe, moyenne, et interne.. Le conduit entre l'oreille externe et l'oreille moyenne est séparé par une fine membrane : le tympan.

Sa partie visible est l'oreille externe qu'on appelle pavillon, nous sert d'antenne acoustique et de capteur. Les sons pénètrent dans le conduit auditif externe.

Les ondes sonores mettent ensuite en vibration le tympan qui obture l'oreille moyenne, située dans une cavité osseuse du crâne. Dans cette cavité, une chaîne de trois osselets, le marteau, l'enclume et 1'étrier, permet de transmettre les vibrations du tympan vers une structure qui sépare oreille moyenne et oreille interne : la fenêtre ovale. Les trois osselets vont servir d'amplificateurs pour compenser la perte d'énergie liée au passage de l'onde sonore du milieu aérien au milieu liquidien de la cochlée dans l'oreille interne. Saisissant les déplacements du tympan, le marteau transmet son énergie à l'enclume, qui la communique à l'étrier.

Pour égaliser les pressions de part et d'autres du tympan un conduit, la trompe d'Eustache relie la cavité de l'oreille moyenne au pharynx, une fonction très utile surtout lors du décollage d'un avion par exemple.

L'étrier (le plus petit os du corps humain) est en contact avec la membrane obturant la fenêtre ovale, point d'entrée dans l'oreille interne où se trouve l'organe de l'audition : la cochlée ou limaçon, sorte de long cône composé de trois tubes ou rampes caractérisés par un enroulement hélicoïdal et remplis de liquide.

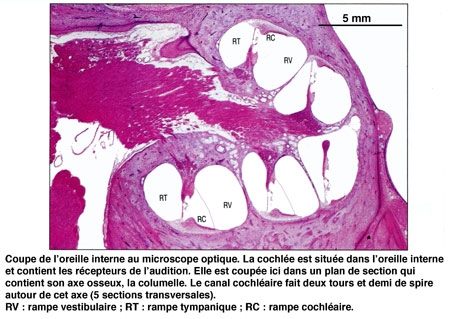

III. L'oreille interne permet de coder les fréquences sonores

1. La membrane basilaire vibre en fonction de la fréquence sonore

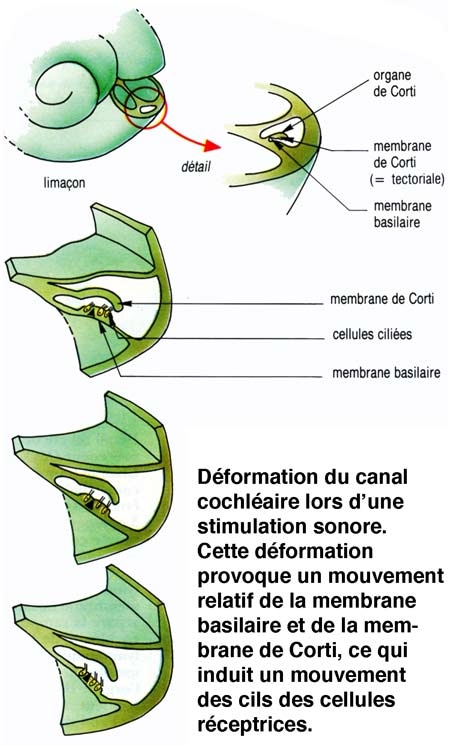

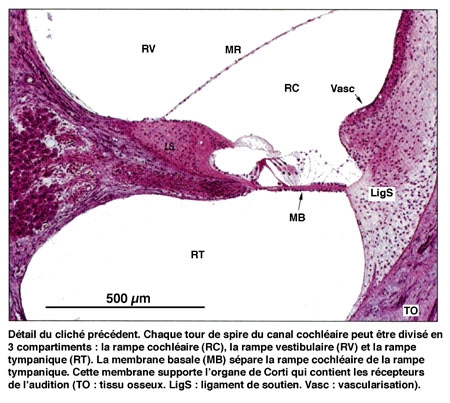

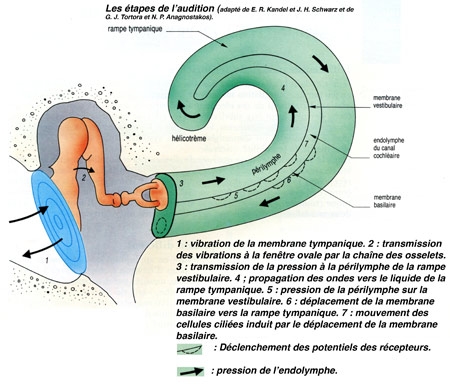

Les vibrations, qui atteignent la fenêtre ovale par l'intermédiaire de la chaîne des osselets, sont transmises au travers des différentes rampes, jusqu'au niveau de la fenêtre ronde. La mise en mouvement du canal cochléaire, et plus particulièrement de la membrane basilaire, provoque un fléchissement rythmique des cils des cellules sensorielles.

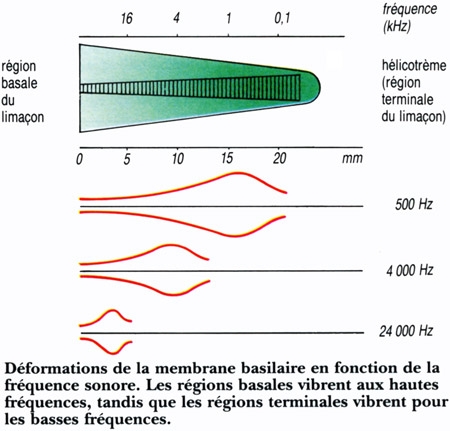

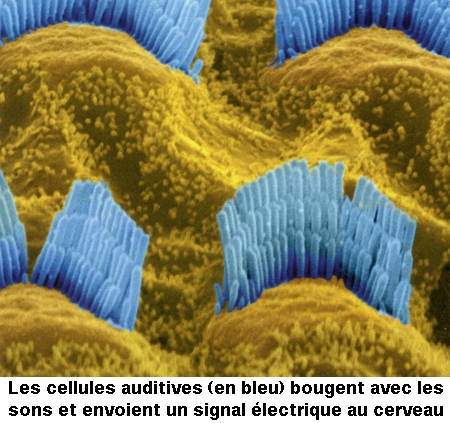

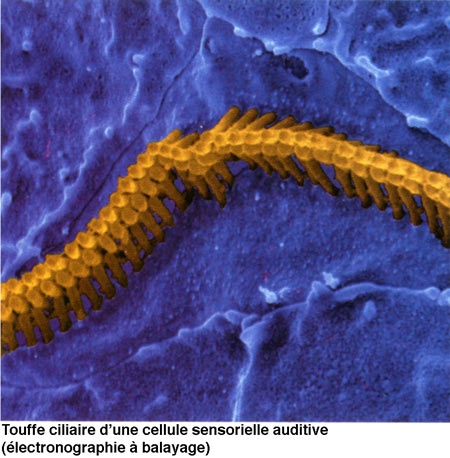

Le canal central contient l'organe sensoriel de l'audition, l'organe de Corti, tapissé des cellules sensorielles auditives : les cellules ciliées (15 000 par cochlée). La rampe vestibulaire et la rampe tympanique contiennent de la périlymphe riche en Na+, et encadrent le canal cochléaire qui, lui, contient de l'endolymphe riche en K+. Les cellules ciliées sont coiffées d'une touffe de stéréocils, qui transforment l'onde sonore en signal électrique. La partie basale de la membrane basilaire, peu large et épaisse, vibre préférentiellement pour des fréquences sonores élevées. À l'opposé, la région terminale (côté hélicotrème) vibre à des fréquences sonores faibles. Le codage de la fréquence sonore est donc directement dépendant de la position des cellules ciliées le long de la cochlée. La rampe tympanique et le canal cochléaire sont séparés par la membrane basilaire qui porte l'organe sensoriel proprement dit, ou organe de Corti. Ce dernier contient des cellules réceptrices ciliées, organisées en trois rangées externes et une rangée interne. L'ensemble est recouvert d'une membrane tectoriale attachée au côté interne de la cochlée.

L'onde sonore amplifiée par l'oreille moyenne est en effet transformée en onde liquidienne qui va mettre en vibration la touffe ciliaire des cellules ciliées. Ces cellules sont des transducteurs : elles transforment les mouvements de leurs stéréocils en signal nerveux transmis au nerf auditif. Le long de la cochlée, chaque cellule ciliée répond préférentiellement à une fréquence sonore donnée, pour permettre au cerveau de différencier la hauteur des sons (batterie de résonateurs) : dans la partie basale de la cochlée sont codés les sons aigus, au sommet les sons graves.

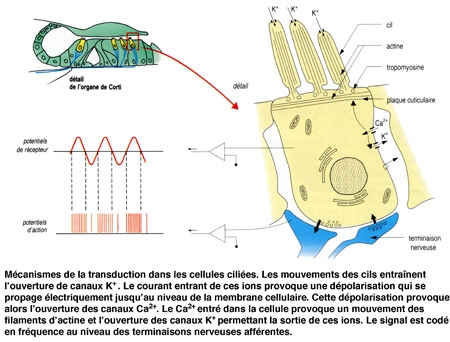

2. Les cellules ciliées assurent le codage de l'information

La différence de potentiel transmembranaire des cellules ciliées varie de façon synchrone avec le mouvement des cils. Au cours du mouvement des cils vers remplacement équivalent du kinocil, la membrane de leur extrémité se déforme, et permet l'ouverture de canaux K+. Les cils baignant dans une endolymphe riche en K+, un courant entrant d'ions positifs (K+) s'établit, provoquant une dépolarisation de la membrane. Cette dépolarisation provoque l'entrée d'ions Ca2+ qui permettent à la fois le mouvement des filaments contractiles de la plaque cuticulaire (ce qui accentue le mouvement des cils) et l'ouverture de canaux K+ situés sur la membrane du corps cellulaire. Ces derniers étant ouverts vers la périlymphe, le courant K+ qui s'établit est un courant sortant, repolarisant la membrane. Le potentiel générateur et les potentiels d'action apparaissent au niveau postsynaptique, dans la fibre sensorielle.

L'oreille interne contient, outre l'organe de l'ouïe, le vestibule, organe de perception de l'équilibre, repérant la position angulaire de la tête et les mouvements d'accélération.

3. Le cerveau traite les signaux

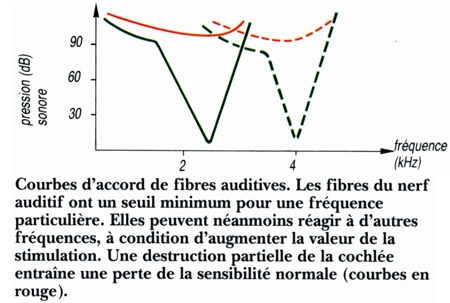

Le cerveau interprète le signal comme un son de la hauteur tonale correspondant au groupe de cellules excitées. L'analyse de l'intensité du son repose, quant à elle, sur divers mécanismes selon la fréquence sonore, le taux de décharges des neurones auditifs et la nature des neurones qui répondent (neurones à haut seuil ou à bas seuil).

Chaque fibre sensorielle est préférentiellement mise enjeu pour une fréquence particulière, mais peut également être mise en jeu par des fréquences différentes. La courbe du seuil de ces fibres en fonction de la fréquence sonore constitue leur courbe d'accord. Au niveau du cortex auditif les cellules sont organisées en colonnes fonctionnelles. Les neurones appartenant à une même colonne ont tous des courbes d'accord semblables. Les informations auditives liées au langage sont ensuite traitées dans des régions corticales particulières. Les aires principales impliquées dans ce traitement sont localisées normalement à l'hémisphère gauche. Ce sont l'aire temporale du langage, encore appelée aire de Wernicke, et l'aire frontale du langage, ou aire de Broca. La première est impliquée dans les processus sensoriels de reconnaissance de la parole, tandis que la seconde est plus directement liée à l'expression orale.

IV. Les surdités

- Origine des surdités

S'il existe quelques rares surdités d'origine centrale (impliquant le cerveau), la grande majorité des surdités est liée à un défaut de l'oreille elle-même.

Les surdités de transmission ont pour origine un défaut de l'oreille externe ou moyenne.

Les surdités neurosensorielles (surdités de perception) ont essentiellement pour origine une atteinte de la cochlée.

Dans ces deux catégories, certaines surdités sont génétiques, d'autres acquises.

- Surdité : la part des gènes

L'audition est un outil majeur de communication, d'autant plus qu'elle est essentielle à l'acquisition de la parole : l'afflux d'informations auditives vers les «aires cérébrales de traitement du langage » est capital dans le jeune âge (au cours des six premières années de la vie - et tout particulièrement entre 0 et 3 ans) pour qu'un enfant apprenne à parler. Si la perception de la parole ou de la musique est une activité essentiellement cérébrale, la première étape du traitement des signaux sonores est effectuée par le système auditif périphérique. En cas de déficit non corrigé des atteintes auditives, le langage oral ne peut être acquis.

- Un millier d'enfants naît sourd chaque année et 65% des plus de 65 ans sont malentendants

Or en France, la surdité sévère ou profonde touche chaque année près d'un millier de nouveau-nés, avec les conséquences mentionnées sur l'acquisition du langage oral et sur le développement du lien du tout-petit avec ses proches. Un individu sur mille est de plus affecté par la surdité plus tard au cours de l'enfance. Ensuite, le pourcentage de malentendants dans la population ne cesse de progresser : 6% entre 15 et 24 ans, 9% entre 25 et 34 ans, 18% entre 35 et 44 ans et plus de 65% après 65 ans. Au total, la surdité concerne plusieurs millions de Français, à divers degrés de perte auditive, avec des conséquences variables sur leur vie sociale, Au-delà des surdités légères, les surdités moyennes ont, chez l'enfant, un impact négatif sur l'apprentissage scolaire, le développement cognitif et l'adaptation sociale. On l'a vu, les surdités profondes contrarient chez lui l'acquisition du langage oral et ont, chez l'adulte, l'isolement social pour conséquence majeure.

Face à ce problème considérable, la génétique a totalement modifié la donne, permettant une meilleure prise en charge des surdités de l'enfant, préparant pour lui de futures thérapies, et plus récemment, apportant un espoir supplémentaire : celui de prévenir les surdités liées au vieillissement.

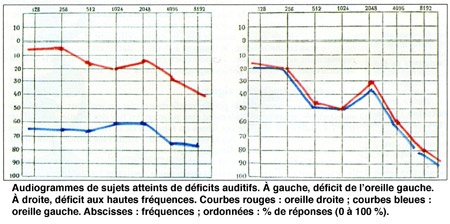

- Surdités tardives : des problèmes de perception des fréquences aux acouphènes

« On peut imaginer l'organe sensoriel auditif comme un clavier de piano, où chaque région traite une fréquence qui lui est spécifique », explique Aziz El Amraoui, de l'unité Génétique et physiologie de l'audition, à l'Institut Pasteur. « La cochlée décompose les sons en ses fréquences élémentaires : les sons aigus (hautes fréquences) sont captées à la base de la spirale cochléaire. les sons graves (basses fréquences) dans sa partie haute. Avec le temps, les sons les plus aigus sont moins bien entendus ». La perte de l'audition avec l'âge s'accompagne d'une difficulté à distinguer les sons, à entendre par exemple une conversation dans un brouhaha. De plus, les surdités acquises sont assez fréquemment accompagnées d'acouphènes, des perceptions auditives (battements, grésillements, sifflements) en l'absence de stimulus externe, souvent très invalidantes : en France, près de 5 millions de personnes en souffriraient. Il semble que la perte auditive s'accompagne d'une augmentation de l'activité spontanée le long des voies auditives du cerveau aboutissant à ces perceptions « fantômes ». « Un rétablissement des entrées sensorielles à un niveau similaire à celui qui prévalait avant la perte auditive réduirait le gain central et supprimerait ainsi les acouphènes », avance Arnaud Norena, de l'Université Aix-Marseille, dans la revue Biofutur (novembre 2012). « Cette prédiction est en partie corroborée par la réduction/suppression des acouphènes produites par les aides auditives, les implants cochléaires et la stimulation acoustique ciblée sur les fréquences de la perte auditive. » Une raison de plus, donc, pour améliorer le traitement des surdités...

V. Les appareils auditifs existants

- Les aides auditives

Avec les aides auditives, le son est capté par un ou plusieurs microphones et le signal traité par un microprocesseur, amplifié, puis réémis via un écouteur dans le conduit auditif externe.

- Les aides en conduction osseuse stimulent directement l'oreille interne à travers les os du crâne ; un microphone capte les vibrations sonores, transmises à l'os temporal par un vibrateur placé derrière l'oreille ; les vibrations de la paroi osseuse autour de la cochlée sont ensuite transférées aux cellules sensorielles. Ces aides auditives sont parfois insuffisantes ou inadaptées à certaines formes de surdité. Deux sortes d'implants peuvent alors optimiser une audition résiduelle ou suppléer des structures défaillantes.

- L'implant d'oreille moyenne, fixé sur un osselet ou à proximité de l'oreille interne, capte les vibrations et les transmet à l'oreille interne.

- Avec l'implant cochléaire, un processeur externe transforme les sons en signaux électriques et les transmet par ondes à la partie interne implantée chirurgicalement, composée d'un ensemble d'électrodes. Ces dernières délivrent des impulsions électriques qui stimulent les fibres du nerf auditif.

- Les trois-quarts des surdités de l'enfant sont d'origine génétique

Dans les années 90, on ne connaissait pas la cause du déficit auditif des enfants qui naissaient sourds. Une équipe de généticiens à l'Institut Pasteur (voir Entretien) localisait alors les premiers gènes associés à des surdités sur des chromosomes humains. Ils firent cette découverte grâce à des collaborations avec plusieurs pays du bassin méditerranéen qui leur permirent de regrouper des données sur de nombreux individus appartenant à différentes familles, caractérisées par une forte consanguinité. Après ces premières grandes analyses génétiques, l'équipe contribua à l'identification d'une trentaine de gènes associés à des surdités, et d'autres dans le monde lui emboîtèrent le pas : 70 gènes impliqués dans des surdités héréditaires sont aujourd'hui connus. L'un d'eux, comme l'ont montre les chercheurs pasteuriens dès 1997, est à lui seul responsable de la moitié de ces surdités [le gène de la connexine 26]. Et l'on sait aujourd'hui que les trois-quarts des surdités de l'enfant sont d'origine génétique, le reste étant notamment dû a des traumatismes ou infections pendant la grossesse.

- Détecter le plus tôt possible les surdités néonatales, pour pouvoir appareiller

Cette aventure scientifique a révolutionné la prise en charge des surdités de l'enfant. Aujourd'hui, grâce aux travaux des chercheurs, des tests de diagnostic moléculaire des surdités les plus fréquentes sont utilisés en routine dans de nombreux pays du monde. Il est en effet important de détecter le plus tôt possible les surdités congénitales. Connaître le gène en cause permet de décider s'il faudra appareiller ou non l'enfant (dans certains cas, heureusement rares, l'appareillage ne résoudra rien] : plus l'enfant pourra entendre tôt, plus le retentissement de la surdité sur ses aptitudes linguistiques sera faible. Les chercheurs ont par exemple montré en 2006 que chez les enfants dont la surdité était due à un défaut du gène de l'otoferline, une protéine nécessaire à la transmission du signal par les cellules sensorielles auditives aux neurones auditifs, la pose précoce d'un implant cochléaire était recommandée alors que les caractéristiques de leur perte auditive conduisaient à s'interroger sur le bénéfice possible de l'implant. Parallèlement à ces avancées, ces recherches ont permis de comprendre de façon plus approfondie le fonctionnement de notre appareil auditif, et tout particulièrement celui de la cochlée, l'organe sensoriel de l'audition logé dans l'oreille interne.

- Un espoir majeur : la thérapie par les gènes

Aujourd'hui, beaucoup d'espoirs sont fondés sur la thérapie génique. Il s'agit là de restaurer la fonction auditive à l'aide du transfert du gène normal [«gène-médicament»], afin de compenser la fonction défectueuse de ce même gène chez le malentendant. Les méthodes envisagées sont diverses, combinant par exemple thérapie cellulaire et thérapie génique : certaines passent par l'introduction du « gène-médicament » dans des cellules souches ensuite différenciées en cellules de la cochlée, puis ré-introduites dans l'organe sensoriel. Les premiers résultats expérimentaux encouragent les scientifiques à poursuivre l'exploration de ces voies thérapeutiques nouvelles. Mais le domaine de l'enfance ne sera pas le seul bénéficiaire de la « révolution génétique » des recherches sur les surdités. Il s'agit désormais d'empêcher la dégradation de l'appareil auditif chez l'adulte. Les surdités de l'adulte, acquises au cours de la vie, sont liées à des traumatismes sonores, des infections (environ 20% des cas sont dus à des otites chroniques), des accidents liés à l'hyperpression (plongée) ou encore à une toxicité médicamenteuse. La plupart de ces facteurs contribuent à la destruction progressive des cellules sensorielles de la cochlée, indispensables à l'audition, et non renouvelables. Le vieillissement contribue par lui-même à une perte auditive qui apparaît le plus souvent à partir de 50-60 ans, la presbyacousie, aujourd'hui irréversible.

- De même que nous avons chacun un « capital soleil », nous aurions aussi un « capital son »

Là encore, la génétique joue un rôle : il existe une grande variabilité dans la sensibilité individuelle à l'atteinte auditive par la surexposition au bruit comme au traumatisme acoustique. Ainsi, chacun d'entre nous serait - selon son ADN - plus ou moins sensible au bruit. De même que nous avons chacun un « capital soleil », nous aurions aussi un « capital son ». Des gènes de prédisposition interviennent également dans notre sensibilité aux médicaments toxiques pour le système auditif (médicaments « ototoxiques »). Les scientifiques sont désormais engagés dans une nouvelle voie de recherche : comprendre comment notre oreille s'abîme, comment elle vieillit. La génétique est un outil majeur dans cette quête. Les réponses trouvées par les chercheurs devraient ouvrir la voie à des solutions thérapeutiques, que ce soit par traitements pharmacologique, génique ou cellulaire, associés ou non à des appareillages « classiques » du type implant cochléaire.

À ce jour - où le diagnostic génétique d'une surdité chez l'enfant est désormais une réalité - la perspective de prévenir l'apparition des surdités liées à l'âge n'a plus rien d'utopique...

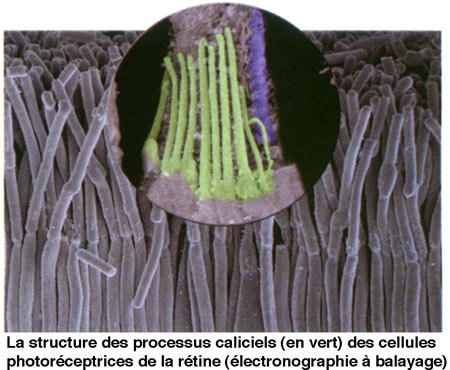

- Face à un syndrome de surdité-cécité : l'espoir de traiter la cécité

L'équipe du Pr Christine Petit à l'Institut Pasteur étudie depuis quelques années une maladie génétique heureusement rare (elle touche une personne sur 10 000) qui associe surdité et cécité : le syndrome de Usher. Les enfants touchés naissent sourds et leur vision est progressivement altérée en raison du développement d'une rétinite pigmentaire. Parmi les différentes formes de la maladie, le type 1 (40% des cas) est le plus sévère : la surdité est profonde et les troubles de la vision apparaissent précocement. S'il existe une bonne prise en charge des patients concernant les troubles auditifs, - notamment grâce aux travaux des chercheurs et des équipes médicales -, aucun traitement ne permet aujourd'hui de stopper l'issue de la rétinite pigmentaire. Or les travaux du Pr Christine Petit[1], en collaboration avec le Pr José-Alain Sahel (Institut de la Vision), ont récemment permis de découvrir l'origine de la rétinite pigmentaire qui touche les patients atteints. Il s'agit d'un défaut dans l'organisation d'édifices cellulaires indispensables au maintien de la vision, les processus caliciels (voir photo) des cellules photoréceptrices de la rétine, dû au dysfonctionnement de l'une quelconque des cinq protéines impliquées dans cette maladie, et qui, ensemble, assurent la cohésion de ces structures. Ces travaux qui définissent les cibles de la maladie vont guider les approches thérapeutiques, aujourd'hui en cours, de cette cécité.

L'interview du Pr Christine Petit

Christine Petit est professeure au Collège de France et à l'Institut Pasteur, responsable de l'unité de Génétique et physiologie de l'audition.

Notre nouvel objectif est de comprendre les processus défectueux dans la surdité tardive pour en prévenir la survenue et la progression.

"Le domaine des surdités héréditaires de l'enfant a été transformé par les recherches de notre équipe."

Comment est née l'approche génétique de l'audition ? L'audition a été initialement explorée par les physiciens - intrigués par les performances exceptionnelles de l'organe sensoriel, la cochlée, qui se comporte comme un analyseur fréquentiel, transforme les sons, signaux mécaniques, en signaux électriques, les amplifie et aussi les distord... -, puis par les physiologistes, et enfin, par les généticiens. Nous avons mis en œuvre une approche génétique de l'audition pour déchiffrer les bases cellulaires et moléculaires du développement et du fonctionnement de la cochlée, qui échappaient jusque là à toute analyse en raison du tout petit nombre de cellules cochléaires. La cochlée ne comporte en effet que quelques milliers de cellules sensorielles auditives. La rétine, pour comparaison, est dotée d'une centaine de millions de cellules sensorielles photoréceptrices. L'intérêt de rapproche génétique pour identifier les molécules requises pour une fonction cochléaire puis en déchiffrer les mécanismes moléculaires correspondants tient au fait que son efficacité est indépendante du nombre de cellules ou de molécules impliquées dans la fonction explorée.

Qu'avez-vous découvert ?

En localisant les premiers gènes responsables de cette atteinte sensorielle sur les chromosomes humains, dans les années 1990, nous avons ouvert le domaine de l'audition à l'analyse génétique. Puis nous avons développé une approche spécifique pour identifier les gènes dont l'atteinte était susceptible d'être à l'origine de surdité chez l'enfant. Cette démarche nous a conduit à la découverte rapide de plusieurs gènes responsables de surdité précoce. Aujourd'hui, 70 de ces gènes sont connus. Par le développement d'approches pluridisciplinaires, impliquant à côté des généticiens, des biologistes cellulaires, des biochimistes, des électrophysiologistes et des physiciens, nous nous sommes ensuite engagés dans l'étude des mécanismes défectueux dans ces surdités. Nous avons pu en parallèle, déchiffrer les mécanismes moléculaires qui sous-tendent certaines propriétés physiologiques connues de la cochlée et éclairer les rôles de plusieurs structures cochléaires. Un grand nombre de laboratoires à travers le monde se sont ensuite engagés dans ce champ disciplinaire. C'est un domaine scientifique et médical particulièrement dynamique.

Quelles applications ces découvertes ont-elles permis pour les surdités de l'enfant ?

Le développement du diagnostic moléculaire de surdité héréditaire permet d'informer les familles qui le souhaitent sur le risque de récurrence d'une atteinte auditive chez les enfants à venir. La connaissance de la pathogénie des diverses formes de surdité permet, dans certains cas, de recommander l'utilisation d'appareils auditifs, en particulier de l'implantation cochléaire, alors que les caractéristiques audiologiques de la surdité suscitent le doute sur leur efficacité. Elle permet parfois, à l'inverse, de conseiller d'éviter tout appareillage auditif et de s'en remettre à des traitements pharmacologiques, dont la connaissance des mécanismes pathogéniques de ces surdités permet de prédire l'efficacité. Aujourd'hui, fondés sur ces avancées, des espoirs de traitements se profilent. Plusieurs laboratoires à travers le monde sont engagés dans la recherche de traitements des surdités, en particulier par voie génétique.

Vous vous intéressez aussi aux surdités tardives. Que peut-on espérer ?

Notre objectif est de comprendre les processus défectueux dans la surdité tardive pour en prévenir la survenue et la progression. On sait que certains gènes prédisposent à la presbyacousie, et aux atteintes auditives liées à une surexposition au bruit. La plupart d'entre eux restent à découvrir. C'est une étape incontournable pour caractériser les processus pathogéniques en cause. Nous identifions par exemple un nombre croissant d'atteintes auditives liées à des perturbations du métabolisme antioxydant que l'on pourrait vraisemblablement prévenir par des médicaments existants. Dans ce but, nous avons créé au cours des dernières années un réseau national qui comporte plusieurs services d'ORL afin de regrouper des familles atteintes de presbyacousie pour rechercher les gènes impliqués. Une analyse approfondie de leur audition a été mise en place. Elle comporte des tests psychoacoustiques pour nous permettre de reconnaître les atteintes de l'intelligibilité de la parole qui sont souvent, chez ces personnes, beaucoup plus sérieuses que ne le prédit la mesure du seuil de leur perception auditive par l'audiogramme. C'est un effort collectif important. Il nous permet aujourd'hui d'analyser environ 150 familles, auxquelles s'ajoute plus d'un millier d'individus atteints. On imagine aisément que le coût de cette recherche, qui repose sur l'analyse exhaustive des génomes de ces personnes, est très élevé.

Glossaire :

Courbe isophone : courbe reliant, sur un audiogramme, les valeurs de pressions sonores entraînant des sensations d'intensité identique.

Décibel (dB) : n.m., unité de pression sonore relative. 1 dB = 20 log.(P/2.10-5 ), où P est la pression sonore exprimée en newton.m-2.

Phone : n. m., unité sans dimension permettant de graduer l'échelle de sensibilité auditive en fonction de la fréquence des sons. La référence se situe à 1 kHz où 1 phone = 1dB.

Cochlée : n.f., partie de l'oreille interne formée de l'enroulement de trois canaux et dans laquelle sont situées les cellules réceptrices sensibles aux vibrations sonores.

Hélicotrème : n.m., extrémité apicale de la cochlée.

Organe de Corti : partie de la cochlée regroupant les cellules sensorielles.

Tympan : n.m., membrane séparant l'oreille externe de l'oreille moyenne.

[1] Menés avec les Drs Azizi El Amraoui et Iman Sahly.

Sources :

- Surdités La lettre de l'Institut Pasteur, revue trimestrielle février 2013.

- Périlleux E., Anselme B., Richard D. (1995). - Biologie humaine, anatomie, physiologie, santé. Ed. Nathan.

18:20 Publié dans Biologie, Environnement-Écologie, Médecine | Tags : audition, oreille, surdité, institut pasteur | Lien permanent | Commentaires (0) | ![]() Facebook | | |

Facebook | | |

Les commentaires sont fermés.